LIPS-Projekt: Networked Music Performances

Gemeinsam an verschiedenen Orten musizieren — und das ohne Delay-Probleme. Wie das geht, erforschte das LIPS-Projekt und stellte nun Ergebnisse vor.

Das Projekt LIPS (Live Interactive PMSE Services) erforschte, wie sich mehrere lokale PMSE-Dienste zu einem professionellen Produktionsnetzwerk kombinieren lassen. film-tv-video.de stellt das Projekt vor und bat dazu Klaus Strazicky, Hermann Popp und Dr. Georg Acher (auch im unten eingefügten Video), unterschiedliche Aspekte des Forschungsprojekts zu erläutern.

Ziel von LIPS war es ganz konkret, räumlich getrennte Standorte in der Produktion unterschiedlichster Events miteinander zu verknüpfen. Auf dieser Basis soll in Zukunft beispielsweise vernetztes Musizieren, aber auch die Realisierung von Remote-Audio-/Videoproduktion und immersiven Konferenzen möglich werden. Darüber hinaus zielt LIPS darauf ab, kulturelle Veranstaltungen, die in Städten stattfinden, etwa Opern, Bühnenaufführungen oder auch Vorträge, auch Teilnehmern aus weit entfernten, abgelegenen und/oder ländlichen Gebieten durch technologische Möglichkeiten besser zugänglich zu machen.

Das Projekt wurde vom deutschen Bundesministerium für Wirtschaft und Technologie co-finanziert, und die folgenden Unternehmen und Forschungseinrichtungen waren an dem Projekt beteiligt:

- Sennheiser

- Arri

- TVN

- Smart Mobile Labs AG (SML)

- Fraunhofer Heinrich-Hertz-Institut (HHI)

- Friedrich-Alexander-Universität Erlangen-Nürnberg (FAU)

- Leibniz Universität Hannover (LUH)

Kurz vorgestellt: Das Forschungsprojekt LIPS.

Wie wichtig ein Projekt wie LIPS letztlich ist, bestätigte sich durch die Corona-Pandemie aufs eindrucksvollste: unterschiedlichste Standorte zusammenzubringen und insbesondere auch für die leidende Kultur- und Kreativwirtschaft neue technische Möglichkeiten aufzuzeigen, ist nun mehr denn je notwendig. Auf der Grundlage neu entwickelter IP-basierter Audio-/Videoproduktionsgeräte zeigt das LIPS-Projekt hier mögliche Lösungen auf.

Abschluss-Event

Am 16. Oktober 2020 präsentierten die Teilnehmer des LIPS-Projekts ihre Erkenntnisse in einem Online-Workshop und beleuchteten die unterschiedlichsten Aspekte in mehreren Vorträgen. Höhepunkt der Veranstaltung war ein gemeinsames Konzert von Musikern vor Ort bei Sennheiser in Wedemark und in der Hochschule für Musik und Theater in München, das durch die Lösungen des LIPS-Projekts ermöglicht und unterstützt wurde.

Grundlagen

Das LIPS-Projekt konzentriert sich auf zwei Hauptbereiche:

- die Verbesserung des immersiven audiovisuellen Erlebnisses für die Benutzer

- die technischen Grundlagen, die eine Verbindung verschiedener Geräte und Standorte zu einem Produktionsnetzwerk erlauben

Von vornherein war klar, dass auch bei Remote-Setups technische Parameter wie Latenz oder Synchronität nicht schlechter sein sollten als bei einer »normalen« Live-Produktion. Angestrebt wurde, das bereits bekannte Qualitätsniveau sogar noch zu verbessern.

Konkretes Test-Setup

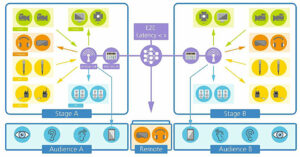

Die Musiker hielten sich an zwei räumlich getrennten Orten auf, waren aber mit der entsprechenden Technik dazu in der Lage, miteinander zu musizieren — und das ohne Laufzeitprobleme. Für eine natürliche Interaktion sollte zudem eine immersive, interaktive audiovisuelle Verbindung zwischen den beiden Orten geschaffen werden.

Konkret: Man wollte eine Art »virtuelles Fenster« schaffen, das die getrennten Räume verbinden sollte und möglichst realistisch wirken sollte. Das stellte hohe Anforderung an Bild, Ton, Licht und Synchronität.

Klaus Strazicky, Hermann Popp und Dr. Georg Acher erläutern unterschiedliche Aspekte des Forschungsprojekts LIPS.

Audio

Um ein immersives Live-Erlebnis zu planen, zu schaffen und zu erhalten, müssen viele Systemaspekte berücksichtigt werden. Die Latenzzeit ist hierbei der kritischste Parameter. Eine wichtige Erkenntnis: Eine Latenzzeit von ca. 25 ms für den Einweg-Übertragungsweg werde von den Musikern als noch nicht störend empfunden.

Synchronität ist ein weiterer entscheidender Faktor, weshalb alle an der Verarbeitungskette beteiligten Geräte auf einen Mastertakt synchronisiert werden. Damit die Musiker auch dann noch gut zusammenspielen konnten, wenn diese Faktoren nicht optimal ausfielen, wurde in der LIPS-Umgebung mit einem »globalen Metronom« gearbeitet.

Dieses Metronom erzeugt auf beiden Seiten einen synchronen Takt. Selbst wenn die Latenzen zwischen den beiden Seiten ansteigen, sind die Musiker dadurch noch in der Lage, synchron zu spielen, ohne dass die Live-Performance darunter leiden könnte.

Ein weiterer wichtiger Aspekt: Um ein immersives Klangerlebnis für die Musiker an beiden Standorten zu schaffen, wurden moderne Techniken der räumlichen Audioaufzeichnung und -wiedergabe eingesetzt — es sollte so klingen, als säßen tatsächlich alle Musiker in einem Raum.

LIPS wollte dabei auch ermitteln, wie die Mikrofonsignale mit unterschiedlichen Latenzen gemischt werden können, um ein hilfreiches Monitorsignal für die Musiker bereitzustellen.

Video

Auch die Videobedingungen innerhalb des LIPS-Projekts waren sehr anspruchsvoll: Die Software und Firmware der Kameras waren speziell für LIPS ausgelegt und boten native All-IP-Funktionalität für Bildübertragung, Synchronisation und Steuerung. Kodierung und Dekodierung fanden innerhalb der Kamera statt, wobei mit ProRes gearbeitet wurde, weil das eine niedrige Latenz für die Komprimierung und Dekomprimierung von unter 10 Millisekunden erlaubte. Als Wrapper wurde MXF genutzt.

LIPS strebt einen kalibrierten, linearen Bildpfad von der Kamera bis zur Bildwiedergabe an, was auch hohe Anforderungen an die verwendeten Displays stellte. Schlussendlich entschied man sich im Projekt für ein großes OLED-Display, das einen Darstellungsmodus mit niedriger Latenz bietet.

Licht

Auch die Beleuchtung spielt für eine gute Immersion eine zentrale Rolle, betont das LIPS-Projekt. Das natürlich verfügbare Licht soll so weit wie möglich erhalten bleiben. Was dann noch an künstlichem Licht hinzukam, wurde für jeden Standort anhand von Beleuchtungsfarbkoordinaten und Beleuchtungsstärke spezifisch berechnet.

Synchronität

Um eine gemeinsame Produktion an räumlich getrennten Standorten zu ermöglichen, muss eine Synchronisation zwischen PMSE-Geräten wie Mikrofonen, Videokameras, (In-Ear-)Monitoren etc. hergestellt werden. Bei gängigen Anwendungen sind die Geräte entweder per Kabel, drahtlos (LTE oder 5G) oder per Wide-Area-Network verbunden, was natürlich unterschiedliche Anforderungen ans jeweilige Setup stelle. Die Synchronität von zwei getrennten Standorten könne mit GPS stabilisiert werden.

Fazit

Ende Oktober 2020 präsentierten die Teilnehmer des LIPS-Projekts online wie auch vor Ort in München und Wedemark ihre Erkenntnisse und Forschungsergebnisse.

Ein Fazit lautet: »Das LIPS-Projekt und sein Anwendungsfall verschieben die Grenzen dessen, was heute innerhalb der vernetzten Musikaufführung möglich ist. Die technologische Konvergenz hin zu einem vollständig IP-basierten Netzwerk, das Audio, Video, Licht und Synchronisierung umfasst, ist ein Schlüsselfaktor für die Unterstützung einer neuen Ebene der Immersion.«

Eine zentrale Rolle könnte hier 5G einnehmen: »Wenn 5G alle identifizierten Anforderungen erfüllen sollte, könnte es eine Lösung für interaktive immersive Dienste über ein Netz sein«, so die Einschätzung.

Mit den nun gewonnen Erkenntnissen aus dem LIPS-Projekt könne man ersten Lösungen entwickeln und testen.

Weitere Infos über LIPS: Der komplette Workshop mit allen Vorträgen.

Keine Infos mehr verpassen und einfach den Newsletter abonnieren: