Stereo-3D in der Live-Produktion: Neuland erforscht

Live-Produktionen in Stereo-3D sind für die meisten noch Zukunftsmusik – auf der Zuschauer- ebenso, wie auf der Produktionsseite. Andere haben sich dagegen schon intensiv mit diesem Thema befasst: Experten von Wireworx präsentierten bei der Hausmesse von Broadcast Solutions die wichtigsten Grundlagen, Technologien, Hintergründe, aktuelle Produkte und mögliche Workflows für Stereo-3D in der Live-Produktion – eine Zusammenfassung.

Kein anderes Thema ist derzeit im Bewegtbildbereich so präsent wie Stereo-3D. Auf den kommenden Messen im Consumer-, wie im Profibereich, wird es dominant sein. Noch immer ist Stereo-3D aber letztlich ein Exotenthema, über das zwar sehr viel geredet wird, bei dem aber vergleichsweise wenig Reales zu greifen ist. Als Schlüssel für den Erfolg auf breiter Basis gilt vielen die Live-Übertragung von Sportereignissen und anderen Events, etwa Konzerten und Kulturereignissen in Stereo-3D. Mit diesem Thema befasst sich das Planungsbüro Wireworx, das unter anderem in die Konzeption und Realisation des ersten von Beginn an auch für Stereo-3D-Produktionen eingerichteten Ü-Wagens aus Deutschland eingebunden ist.

Der folgende Artikel gibt – basierend auf einer Präsentation von Wireworx – einen Abriss, welche Anforderungen und Abläufe die Live-Produktion in Stereo-3D mit sich bringt.

Stereo-3D-Grundlagen

Das Grundprinzip aller momentan gängigen Stereo-3D-Verfahren beruht darauf, zwei leicht versetzte Bilder aufzunehmen und dafür zu sorgen, dass die Zuschauer jedes dieser beiden Bilder mit nur einem Auge sehen. Das menschliche Gehirn kann dann aus diesen Bildern einen räumlichen Eindruck gewinnen – wobei auch Aspekte wie Erfahrung und Sehgewohnheiten eine wesentliche Rolle spielen.

Versucht man diesen Vorgang mit Film- oder Videokameras in einem Live-Umfeld umzusetzen, ist ein wenig Theorie unumgänglich. Deshalb sind im folgenden zunächst einige zentrale Begriffe aus diesem Themenbereich kurz erläutert und vereinfacht definiert, die im weiteren Verlauf dieses Beitrags wichtig sind.

Interokularabstand: Abstand zwischen den Augen, der üblicherweise mit 6,5 cm angegeben wird, auch wenn der individuell verschieden ist. Werden zwei Kameras nebeneinander platziert, spricht man beim Abstand zwischen den optischen Achsen der beiden Kameras auch von der Interaxial-Distanz.

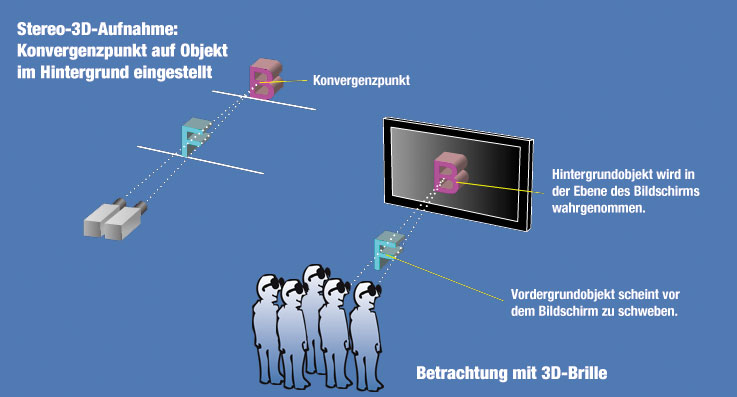

Konvergenz: Denkt man sich zwei Linien, die jeweils vom Auge zu einem Gegenstand laufen, der betrachtet wird, so schneiden sich diese Linien im Objekt. Dieser Schnittpunkt definiert den Abstand zwischen Kamera und Konvergenzebene – in dieser Entfernung von der Kamera sind rechtes und linkes Bild deckungsgleich. Der Winkel, den die gedachten Linien bilden, wird als Konvergenzwinkel bezeichnet. Je weiter der betrachtete Gegenstand von der Kamera entfernt ist, desto kleiner ist der Konvergenzwinkel und desto geringer ist der räumliche Eindruck, der entsteht. Bei Objekten im Nahfeld verändert sich der Konvergenzwinkel sehr stark, wenn sich der Abstand zum Objekt verändert.

Parallaxe: Hält man den Daumen in einigem Abstand vors Gesicht und betrachtet ihn abwechselnd mit dem linken und rechten Auge, entsteht der Eindruck, der Daumen springe hin und her. Dieser Effekt heißt Parallaxe, und ist umso größer, je näher man den Daumen zu den Augen bringt.

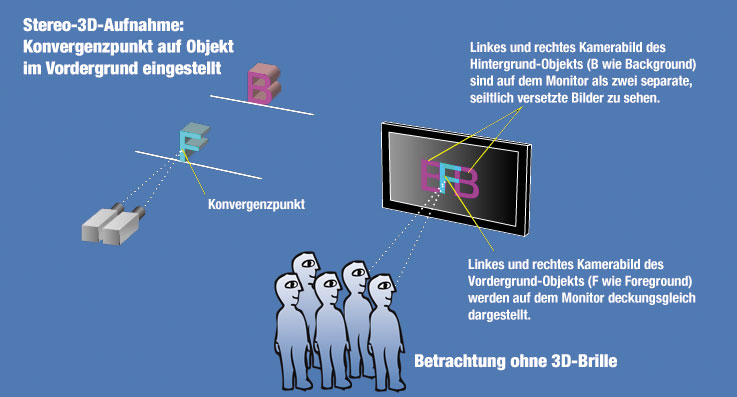

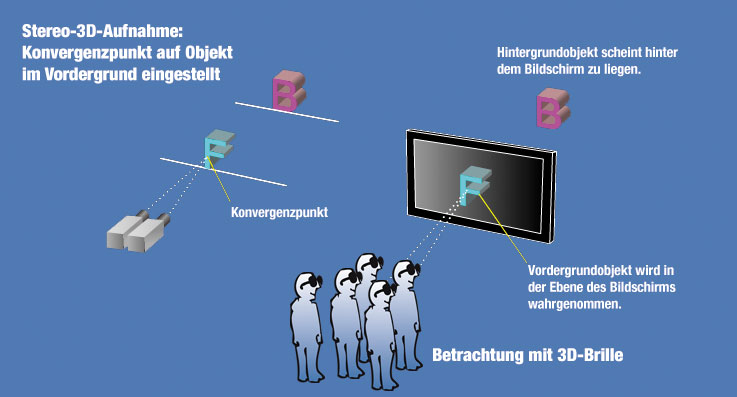

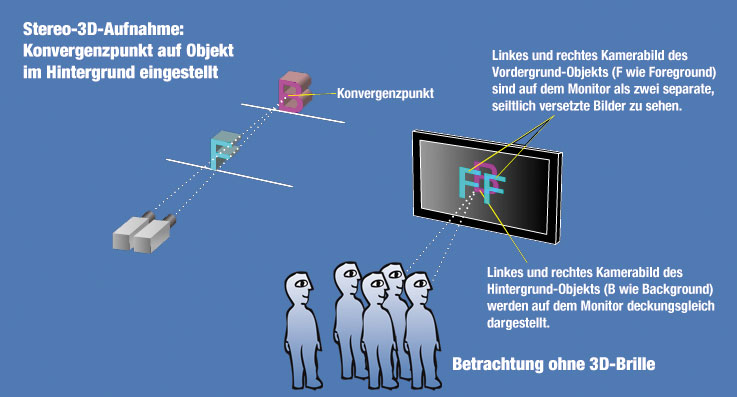

Praktische Anwendung: Baut man das menschliche Sehen mit zwei Kameras nach, dann nehmen diese Kameras – auch aufgrund der Parallaxe – zwei getrennte, unterschiedliche Bilder auf. Nur dort, wo sich die optischen Achsen der Kameras schneiden, in der Konvergenzebene, kommen rechtes und linkes Bild zur Deckung, man spricht auch von Null-Parallaxe.

Was bei der Aufnahme vor der Konvergenzebene liegt, scheint beim späteren Betrachten aus dem Display heraus in den Raum versetzt (negative Parallaxe), was dahinter liegt, wirkt nach hinten verschoben (positive Parallaxe). Die Konvergenz bestimmt also die Objektposition im 3D-Raum.

Objekte, die in der Konvergenzebene liegen, sieht man bei der Vorführung auch ohne 3D-Brille relativ scharf. Objekte, die vor oder hinter der Konvergenzebene liegen, werden dagegen beim Betrachten ohne 3D-Brille mit Doppelkonturen dargestellt. Vor und hinter der Konvergenzebene werden die Bildobjekte seitlich gegeneinander verschoben dargestellt, je weiter entfernt von der Konvergenzebene, umso stärker.

Probleme beim Betrachten von Stereo-3D entstehen bei den Zuschauern, wenn den Augen »unnatürliche« Bildkombinationen zugeführt werden: Wenn rechtes und linkes Bild auseinanderlaufen (Divergenz), wenn sie vertikal springen (V-Shift) oder unterschiedliche Objektgrößen aufweisen.

Stereo-3D in der Praxis

Mit Stereo-3D beschäftigen sich auch einige Sender in Deutschland. Mit HD Broadcast gibt es in Deutschland zudem den ersten TV-Dienstleister, der einen neuen, von Beginn an auch für Stereo-3D ausgelegten Ü-Wagen bauen lässt. Stereo-3D ist somit auch hierzulande in der Live-Produktion angekommen.

Die ersten Tests in der Live-Produktion von Stereo-3D sind erfolgt und spätestens seit der Fußball-WM, bei der 25 Spiele in Stereo-3D produziert wurden, liegen Erfahrungswerte in größerem Umfang vor, die im folgenden zusammengefasst sind.

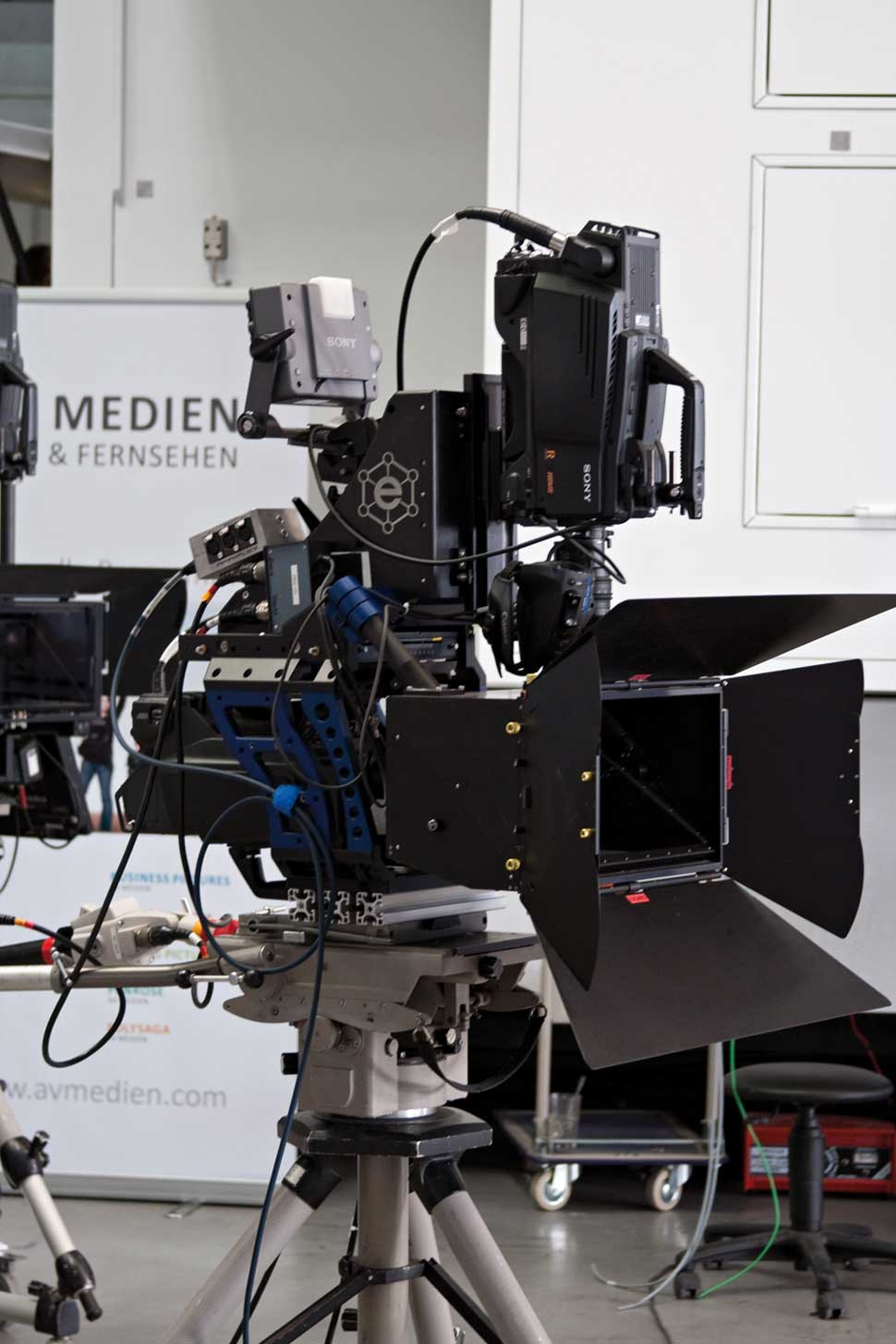

Kameratechnik und Rigs

Das Kamera-Setup sollte es erlauben, bei Änderungen der Kameraposition zum Objekt auch die Abbildungsparameter Schärfe, Konvergenz und gegebenenfalls Brennweite der beiden Objektivsysteme absolut synchron zueinander zu verändern. Das stellt einige Anforderungen ans Kamera-Set-Up und die Art und Weise, in der die beiden Kameras auf ein Rig montiert werden.

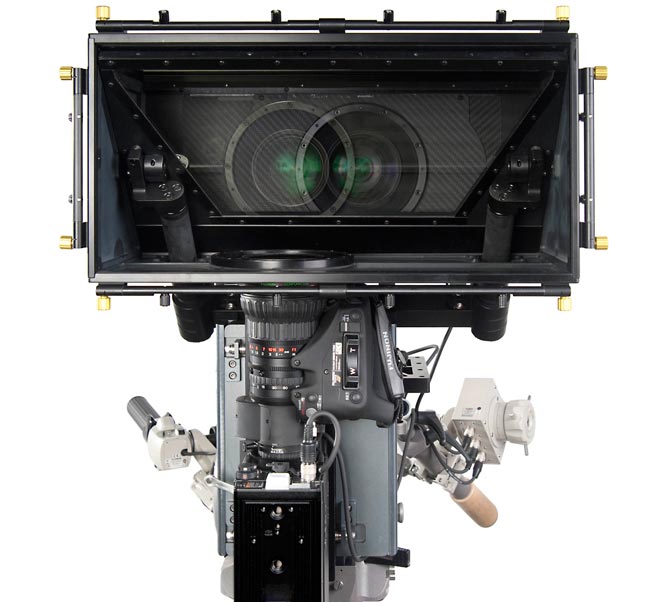

Prinzipiell unterscheidet man zwischen Side-by-Side- und Beamsplitter-Rigs. Bei den Side-by-Side-Rigs werden zwei Kameras nebeneinander montiert. Das ermöglicht in der Regel einen schnellen Auf- und Abbau der Kamera-Setups, was im AÜ-Bereich Vorteile bietet. Side-by-Side-Rigs haben aber den Nachteil, dass bei Einsatz normaler Broadcast-Kameras durch deren Baugröße die Interaxial-Distanz in der Regel größer ist als 6,5 cm. Der Objektabstand sollte bei solchen Rigs mehr als fünf bis acht Meter betragen, wenn man eine realistische, für die Zuschauer gut verträgliche Stereo-3D-Aufnahme erzielen will. Im Live-Sport gibt es durchaus Kamerapositionen, in denen Side-by-Side-Rigs ihre Berechtigung haben.

Die überwiegende Anzahl gängiger Rigs arbeitet aus den genannten Gründen mit einer anderen Kameraanordnung und dem Beamsplitter-Prinzip: Dabei werden die Kameras im rechten Winkel zueinander montiert, zwischen den Objektiven ist ein halbdurchlässiger Spiegel im 45-Grad-Winkel angeordnet. Diese Bauweise erlaubt es, den Interokularabstand selbst mit großen, sperrigen Kameras richtig zu justieren. Dadurch ist ein geringerer Objektabstand möglich, was diese Systeme insgesamt flexibler macht.

Manche Beamsplitter-Rigs lassen sich zudem in unterschiedlichen Konfiguration nutzen, um möglichst flexibel zu sein: Die vertikale Kamera kann von unten oder von oben auf den Spiegel gerichtet werden.

Bei von unten montierter Kamera wírd eine kompaktere Silhouette erreicht, wodurch das Kamera-Setup etwa für Zuschauer hinter der Kameraposition weniger störend ist. Bei von oben montierter Kamera bleibt dagegen mehr Platz zum Neigen des Rigs. Nachteile gibt es bei Beamsplitter-Rigs allerdings auch: Aufbau und Justage sind komplexer, zudem ist bei vielen Kameratypen aufgrund der Anordnung der Kameras ein externes H/V-Flipping des Kamerasignals notwendig. Außerdem muss man bei diesen Rigs mit dem Verlust einer Blendenstufe durch den halbdurchlässigen Spiegel leben.

Manuelle und motorisierte Rigs

Bei den bisherigen Stereo-3D-LiveProduktionen haben sich einige Rigs als besonders praktikabel erwiesen: So sind beispielsweise beim manuellen Standard-Rig von P+S wie auch beim Swiss Rig Interaxial-Differenz wie auch Konvergenz manuell verstellbar. Beide Rigs lassen sich mit den »normalen« Full-Body-Kameras nutzen, die im Broadcast-Bereich üblich sind. P+S Technik bietet zudem mit dem Freestyle Rig ein kompaktes Modell an, das via Handfernbedienung gesteuert werden kann und mit Stellmotoren ausgerüstet ist.

Motorisierte Rigs wurden bei der Fußball-WM eingesetzt. So nutzte der Fifa-Dienstleister HBS Quasar-Rigs von Element Technica. Sie haben den Vorteil, dass sie sich modular sowohl als Side-by-Side wie auch nach dem Beamsplitter-Prinzip aufbauen lassen. Weiter ist das Quasar-Rig mit Stellmotoren für Interaxial-Differenz und Konvergenz bestückt, zudem ist die Steuerung des Rigs per Handfernbedienung oder über den Sony-3D-Prozessor MPE-200 möglich.

3D-Pionier 3ality bietet mit der TS-Serie ebenfalls ein motorisiertes System inklusive des 3D-Prozessors SIP 2100/2900 an. Kamera, Optik und das komplette Rig lassen sich mittels Stellmotoren motorisiert per Handfernbedienung einstellen.

Synchrone Bedienung

Bei der 3D-Produktion muss neben der Brennweite und dem Zoomwert auch die Schärfeneinstellung der beiden Objektive jedes Kamerapärchens zu jedem Zeitpunkt übereinstimmen. Hierfür hat Fujinon das 3D Synchronous Control System entwickelt. Es besteht aus dem Zoomgriff ERD-10A-D01 sowie dem Fokusgriff und Synchronizer HJ-303A-06A. Zwei Kabel vom Typ SA-206H stellen die Verbindung zwischen dem 3D-Controller und den Optiken her. Das System synchronisiert die Objektive für linkes und rechtes Bild, Zoom- und Fokuswerte beider Optiken werden exakt aufeinander abgestimmt. Canon bietet eine ähnliche Möglichkeit für die Synchronisierung von HD-Optiken mittels Splitter-Box an.

Trotz solcher synchronisierten Steuersysteme kann es aufgrund der Summe von kleineren Toleranzfehlern sowohl der Optiken als auch des Kameraflansches und der CCD-Chip-Montage zu Abbildungsabweichungen zwischen zwei Optiken kommen. In solchen Fällen sind Korrekturen über externe Hardware nötig (mehr dazu im Abschnitt MPE-200).

Für Stereo-3D-Produktionen ist es zudem wichtig, Kameras via OCP synchron bedienen zu können. Sony stellte zu diesem Zweck mit RCP-1500 eine Steuerung vor, die sich mittels Firmware-Update so einrichten lässt, dass man von einer OCP aus gleichzeitig zwei Kameras steuern kann. Dies erleichtert die Steuerung und das Matching der Kameras im Stereo-3D-Betrieb für den Bildtechniker erheblich. Grass Valley bietet dies analog mit der OCP-400 an.

MPE-200, Konvergenzoperator, Stereographer

Sony hat mit der Prozessorbox MPE-200 eine Analyse-Hardware für Stereo-3D-Live-Produktionen entwickelt, die gleich mehrere Funktionen bietet: Als Analysewerkzeug hilft die Box den Technikern beim Einrichten des mechanischen Setups der beiden Kameras auf dem Rig. Bei den 3D-Produktionen der Fifa-WM etwa war in die Signalkette jedes Kamerapärchens ein MPE-200 eingebaut.

Stimmen Rotation, Vertical-Shift, Interaxial-Differenz und Konvergenz der Kameras? Hierfür erhalten die Konvergenzoperatoren in der Aufbau- und Justagephase den Waveform-Ausgang des jeweiligen MPE-200 als Kamera-Rückbild. Nachdem das Rig mechanisch optimal justiert wurde, beginnt dann das Abgleichen der optischen Achsen der Objektive. Bedingt durch den Einsatz von Zoomobjektiven, kommt es zu einer Verschiebung des Bildmittelpunktes in Abhängigkeit von der Brennweite. MPE-200 ist in der Lage, diesen Bildfehler digital zu korrigieren und in Abhängigkeit des jeweiligen Brennweitenwertes zu speichern. Nach einem einmaligen Justage-Durchlauf ist gewährleistet, dass die optische Achse des Bilds auch bei Zoomvorgängen gleich bleibt und sich nicht durch die unvermeidlichen Linsenfehler und Toleranzen der Objektive und des Kameraflansches verschiebt.

Bleibt noch das Problem, dass die Optiken der beiden Kameras bei Zoom und Fokus-Vorgängen nicht absolut synchron laufen, wenn nicht einer der oben erwähnten Objektiv-Synchronizer eingesetzt wird. Die MPE-200-Box kann auch diesen Fehler digital auffangen, in dem sie das betreffende Bild up- oder down-skaliert und den Korrekturwert in Abhängigkeit der Brennweiteneinstellung des betreffenden Objektives speichert. Auch diese Justage muss also nur einmal durchgeführt werden, die permanente, jeweils passende digitale Korrektur erfolgt dann während des Sendebetriebs automatisch.

Während der Sendung steuert der Konvergenzoperator dann nur noch die Interaxial-Differenz und die Konvergenz der Kameras auf dem Rig. Hierfür hat Sony die Software MPES-3D01 entwickelt, mit der sich der Prozessor MPE-200 in dieser Phase übersichtlich steuern lässt. MPE-200 analysiert die Parallaxe und zeigt Fehler wie »Überbasis« an.

Erforderlich ist das, weil Brennweitenveränderungen (also das Zoomen) zu Veränderungen der Parallaxe führen, die korrigiert werden müssen. Parallaxen-Sprünge sind zudem bei den Umschnitten von Kamera zu Kamera extrem störend für den Betrachter und müssen durch Anpassung der Konvergenzeinstellung vermieden werden. Hierfür gibt es den zusätzlichen Job des Stereographers, dem die Konvergenzoperatoren untergeordnet sind. Die Konvergenzoperatoren regeln also Interaxial-Differenz und Konvergenz des jeweiligen Rigs entsprechend der Anweisungen des Stereographers.

Bildgestaltung

Bei Stereo-3D-Live-Produktionen ist es nicht sinnvoll, in den klassischen 2D-Konventionen zu denken. Es empfiehlt sich aus Sicht von Wireworx, mit weniger Kamerapositionen zu arbeiten und diese möglichst nah am Objekt aufzubauen. Auf lange Brennweiten sollte generell ebenso verzichtet werden, wie auf hohe Zoomfaktoren, da hierdurch der Tiefeneindruck verloren geht. Auch in der Bildführung sollte umgedacht werden: Reiß-Schwenks oder Zoomfahrten sind für Stereo-3D ungeeignet. Insgesamt sollte weitwinkliger aufgezeichnet und mit weniger Schnitten gearbeitet werden.

Die Gesetze der 2D-Bildgestaltung, die sich im Laufe der Kino- und Fernsehgeschichte entwickelt haben, können nur teilweise auf Stereo-3D-Produktionen übertragen werden. Im 3D-Bereich muss sich eine angemessene Bildsprache erst entwickeln. Hierzu zählt außer der Kamerapositionierung, der Wahl des Bildwinkels natürlich auch die Art und Weise wie sich die Akteure im 3D-Raum bewegen.

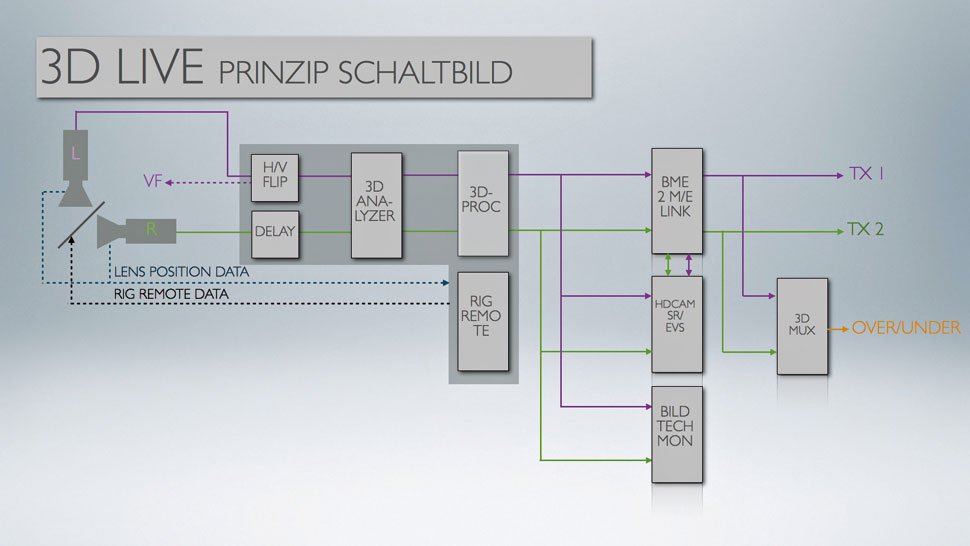

Sendeablauf

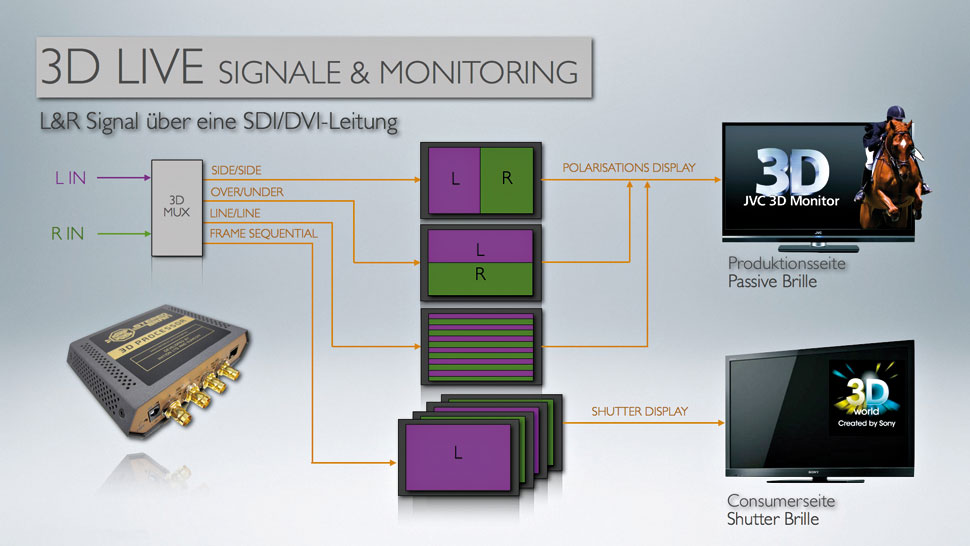

Die Bearbeitung der Stereo-3D-Signale erfordert im Ü-Wagen umfassende Kapazitäten und zusätzliche Hardware. Das Blockschaltbild in der Bildleiste rechts zeigt die einzelnen Signalwege und -stationen. Das Monitoring der Signale ändert sich und die Aufbereitung für unterschiedliche Wiedergabe-Stationen ist nötig: Mit entsprechenden Prozessoren, etwa dem StereoBrain 3D Processor von Inition ist es möglich, Stereo-3D-Signale auf unterschiedliche Weise fürs Monitoring auszugeben: Side/Side, Over/Under, Line/Line oder Frame Sequential stehen zur Verfügung, um aktive Displays zu füttern, die mit Shutter-Brille arbeiten, oder passive 3D-Schirme.

Wenn es schließlich um die Übertragung der Stereo-3D-Signale geht, bieten sich 3D-Mix-Verfahren wie Side-By-Side oder Over/Under über nur einen SDI-Stream als kostengünstige Lösung an. Allerdings halbieren sie die horizontale oder vertikale Auflösung auf jedem Auge, was gerade bei Produktionen, mit teuren Senderechten nicht erwünscht ist.

HBS hat daher bei der Fußball-WM die beiden L/R-Signale des Stereo-3D-Feeds separat über zwei Uplinks vom Ü-Wagen abgesetzt werden. In hoher Signalqualität, mit 300 Mbps im JPEG2000-Codec, wurde der Hauptschaltraum im IBC von den Ü-Wagen versorgt, um das 3D-Bild in hochwertiger Sensio-Technologie an die angeschlossenen Kinos in Europa weiter zu verteilen. Tests von HBS haben zudem so etwas wie einen Mindeststandard ergeben, den das Unternehmen auf keinen Fall unterschreiten will: 40 Mbps bei MPEG-2-Kompression. Niedrigere Datenraten bergen demnach die Gefahr, durch Kompressionsartefakte auch den Stereo-3D-Eindruck zu beeinträchtigen.

Empfehlungen der Redaktion:

10.05.2010 – WM-Countdown: Erfolgreicher Abschlusstest für Stereo-3D-Übertragung in Monaco

03.09.2010 – Sky plant regelmäßige Stereo-3D-Übertragungen

16.03.2010 – Erfolgreicher Test bei Sky: Bundesliga-Fußball in Stereo-3D