Grundlagen der Stereo-3D-Technik

Die Film- und TV-Branche erhofft sich von der 3D-Stereoskopie wichtige Impulse und die Erschließung neuer Marktpotenziale. Wer hochwertig produzieren will, sollte allerdings die technischen Grundlagen der Stereo-3D-Technik kennen und berücksichtigen, die dieser Beitrag erläutert und zusammenstellt.

Kein Zweifel: Das Thema Stereo-3D wird derzeit in der Branche weit über seine reale Marktbedeutung hinaus aufgeblasen. Wer realistisch auf den Produktionsmarkt und den Endkundenbereich schaut, muss erkennen, dass Stereo-3D auf absehbare Zeit ein Nischenmarkt bleiben wird — zumindest jenseits des Animationsfilms. Das gilt aber auch für viele andere Themen — und auch Nischenprodukte können sehr interessant und lukrativ sein. Also lohnt sich der Blick auf die grundlegenden Aspekte von Stereo-3D, die dieser Artikel zusammenfasst.

Stereo-3D-Filme können sehr beeindruckend aussehen, wenn sie technisch gut gemacht sind — auf dem langen Weg von der Idee bis ins Kino gilt es hierfür aber auf technologischer Seite einige Hürden zu bewältigen, denn noch immer lässt sich das menschliche Sehen in seiner Komplexität mit technischen Geräten nur unvollständig nachbilden. Das liegt nicht nur daran, dass sich jeder Mensch in seinen individuellen Sehgewohnheiten unterscheidet, sondern auch daran, dass viele Faktoren die 3D-Wahrnehmung beeinflussen, darunter zahlreiche wahrnehmungspsychologische aber auch geometrische Aspekte. Will man ein hochwertiges Stereo-3D-System entwickeln, das ein möglichst großes Publikum anspricht, sind Kompromisse nötig, die beim Einzelnen zu Abstrichen in der individuellen, subjektiv empfundenen Bildwiedergabequalität führen.

Dennoch ist es möglich, dem Ideal durch technische Maßnahmen erstaunlich nahe zu kommen. Voraussetzung dafür ist allerdings, dass schon bei der Stereo-3D-Aufnahme einige wichtige Punkte berücksichtigt werden. Fehler die sich hier einschleichen, lassen sich später kaum mehr wirkungsvoll korrigieren.

Grundlagen des räumlichen Sehens

Betrachtet man das menschliche Auge als »Bildaufnahmesensor« und vergleicht es mit einem künstlichen Bildwandler, weist das Auge beim heutigen Technikstand in aller Regel eine höhere optische Auflösung auf. Doch ebenso wie ein künstlicher Sensor, produziert auch das Auge eine zweidimensionales Abbild der Umgebung — umgekehrt zur Blickrichtung. Dann allerdings geht es weitaus intelligenter und effizienter weiter, denn die »Bildgewinnung« geschieht nicht etwa durch die vollständige Erfassung eines gleichmäßig aufgelösten Vollbildes auf der Augennetzhaut. Vielmehr nimmt das Auge die Umgebung zunächst nur mit durchaus unterschiedlicher Qualität in Teilbereichen war und setzt daraus ein Gesamtbild zusammen. Der eigentliche zur Bilderfassung genutzte, scharf wiedergebende Bereich der Netzhaut beträgt nur etwa 0,02 Prozent der Netzhautoberfläche. Das entspricht einem Erfassungswinkel von etwa 2 Grad für das »scharfe Sehen«, während der gesamte horizontale Sichtwinkel etwa 200 Grad beträgt.

Die genauere Erfassung geschieht durch wechselnde Blicke auf unterschiedliche Bildteile, wobei ein Teil der Bilderkennung durch einen unbewusst ablaufenden Scan-Vorgang charakteristischer Bildteile abläuft. Der scharf abbildende Teil des Blickfeldes ruht bei diesen Scan-Vorgängen für jeweils 0,2 bis 0,6 Sekunden auf einem Bildteil, bevor er zum nächsten charakteristischen Bildteil weiterspringt. Diese Bewegungsvorgänge nennt man Sakkaden. Aus den gewonnenen Einzelbildern setzt das Gehirn schließlich eine Bildinformation zusammen. Letztlich kann man also sagen, dass schon die zweidimensionale Bilderfassung in einer zeitlich gedehnten Abfolge stattfindet.

Wie kann man ein Objekt oder ein Motiv dreidimensional erfassen? Das wird möglich, wenn man mit einem zweidimensional reproduzierenden Sensor den Standpunkt um ein kleines Quäntchen ändert. Verändert sich das Objekt relativ zum Auge, unterstützt das ebenfalls die räumliche Erfassung, und aus dem Vorher/Nachher-Vergleich kann man Rückschlüsse auf die räumliche Ausdehnung eines Gegenstandes ziehen.

Der Mensch hat mit seinen Augen im Grunde zwei »Bildaufnahme-Sensoren«, die in einem festen Abstand zueinander stehen und de facto »in Echtzeit« einen Vorher/Nachher-Vergleich erlauben. Darüber gewinnt der Mensch nicht nur Informationen über das Objekt oder den Gegenstand, den er sieht, sondern erhält zusätzlich eine gänzlich andere Art der Orientierung, denn das menschliche Gehirn ist durch erlernte, antrainierte Seh- und Erfassungsgewohnheiten in der Lage, sich dreidimensionale Geometrien, ja ganze räumliche Strukturen zu merken: Dreidimensionales Sehen beruht also auch auf Erfahrung, auf der Erkennung von Mustern, der Interpolation und der Vermutung von Gegenstandseigenschaften. Das Gehirn vergleicht dazu laufend die zum jeweiligen Augenblick gesehenen Bildinformationen mit gespeicherten Rauminformationen aus vorhergehenden Tast- und Sehvorgängen. Das klingt gleichermaßen abstrakt wie auch vereinfacht, bildet aber die Grundlage des Lernprozesses, mit dem unser räumliches Sehen antrainiert wird.

Die im Laufe eines Lebens gesammelte Seherfahrung führt dazu, dass der Mensch ganz bestimmte Dinge erwartet, wenn er diese oder jene Oberfläche und Beschaffenheit wahrnimmt. Technische Systeme, die das dreidimensionale Sehen nachbilden sollen, dürfen also diese Erwartungen nicht enttäuschen, wenn das Zusammenspiel aus Auge und Gehirn des Menschen sie als natürlich akzeptieren soll.

Um zu verstehen, was das Auge leistet, lohnt sich die Übertragung von dessen Eigenschaften auf ein technisches System: Es bietet eine feste Brennweite, einen einstellbaren Fokus, eine automatisch arbeitende Iris, einen automatischen Weißabgleich und eine Adaptionsmöglichkeit auf niedrige Beleuchtungsstärken. Das Sehen mit einem einzelnen Auge ist vom optischen Grundprinzip her zunächst also recht unspektakulär. So lassen sich zwar Gegenstände anvisieren, scharf einstellen und mit der richtigen Belichtungseinstellung registrieren, es fehlt aber der räumliche Seheindruck. Dieser wird, wie bereits erwähnt, erst dadurch möglich, dass beide Augen den Gegenstand aus zwei geringfügig voneinander entfernten Betrachtungspunkten ansehen. Die Einstellung der beiden Augen zueinander und zum Betrachtungsobjekt muss dabei sehr exakt erfolgen.

Parameter des Sehens

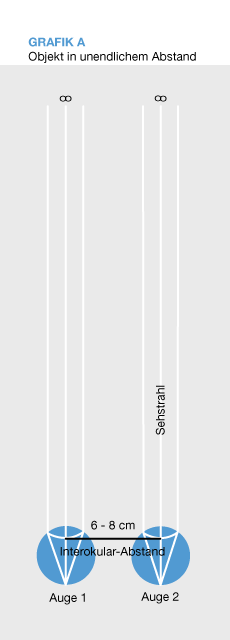

Konvergenz, Interokularabstand, Fokussierung

Denkt man sich zwei Linien, die jeweils vom Auge zum betrachteten Gegenstand verlaufen, so stehen diese beiden Linien in einem bestimmten Winkel zueinander und schneiden sich im Objekt. Soll heißen: Je weiter weg sich der betrachtete Gegenstand befindet, desto kleiner ist der sogenannte Konvergenzwinkel und desto geringer ist auch der räumliche Eindruck, den der Mensch gewinnen kann. Im Nahfeld verändert sich der Konvergenzwinkel allerdings sehr stark, wenn sich der Abstand zum Objekt verändert. Bei der technischen Nachbildung des Sehvorgangs ist es deshalb sehr wichtig, den Konvergenzwinkel mit hoher Genauigkeit dem Objektabstand anzupassen. Schon früh erkannte man, dass es erforderlich ist, die Konvergenzbewegungen des Auges, also das Zusammenlaufen der Sehstrahlen in einem endlich entfernten Punkt, im Kamera-Setups nachzubilden. Einfache Konstruktionen begnügen sich hierbei mit einer rein manuellen Justage-Einrichtung, die es nicht ohne weiteres erlaubt, Abstandsänderungen des Objekts nachzuvollziehen. Es ist bei solchen Systemen also notwendig, bei jeder neuen Einstellung die Konvergenz auf den aktuellen Objektabstand einzustellen.

Den Abstand zwischen den Augen oder Sensoren nennt man Interokularabstand. Er beträgt beim Menschen etwa sechs bis acht Zentimeter, ist aber von Person zu Person unterschiedlich. Der Konvergenzwinkel wiederum hängt direkt vom Interokularabstand ab, wenn man von einem konstanten Betrachtungsabstand ausgeht. Es ist deshalb nicht möglich, bei der technischen Nachbildung des Sehvorgangs einen für alle Betrachter optimalen Konvergenzwinkel einzuhalten, wenn man den Interokularabstand in der Aufnahmevorrichtung konstant einstellt. Trotzdem muss man mit dieser Ungenauigkeit leben, da eine individuelle Nachbildung dieses Parameters bei der Vorführung derzeit noch nicht möglich ist.

Bei Objektabstandsänderungen muss das Auge durch Fokussieren auf die Abstandsänderung reagieren, um ein scharfes Abbild auf der Netzhaut zu gewinnen. Das Konvergieren und Fokussieren geschieht bei einem gesunden Auge automatisch immer auf den Punkt, der gerade anvisiert wird. Diese Einstellung erfolgt in Sekundenbruchteilen, das System aus Auge und Gehirn hat dies im Laufe eines optimierenden Lernprozesses trainiert.

Aus dem Wechsel der Betrachtungspunkte, der damit wechselnden Einstellungen des Auges und den daraus resultierenden Bildern der beiden Augen hat das Gehirn gelernt, eine dreidimensionale Information über die Umgebung des Gesichtsfeldes zu erzeugen.

Helligkeitsrezeption, Adaption

Das menschliche Auge hat zudem die Fähigkeit, sich innerhalb physiologischer Grenzen der Änderung der Umgebungshelligkeit anzupassen. Bei einer Leuchtdichte größer als etwa 3,4 cd/m2 geschieht das dadurch, dass sich der Durchmesser der Pupille ändert: Er wird größer, wenn es dunkler und kleiner, wenn es heller wird. Bei einer noch geringeren Leuchtdichte stellt das Auge auf einen andere Rezeptorentyp um (von Zäpfchen auf Stäbchen, ohne diesen Unterscheid hier näher erläutern zu wollen).

Die Pupillengröße wird durch einen Ringmuskel am äußeren Rand hinter der Iris verändert, der Befehl dazu kommt vom Gehirn. Diese »Belichtungsregel« hat eine relativ kurze Reaktionszeit, die im Millisekundenbereich bis hin zu einigen Zehntel Sekunden liegt. Das menschliche Auge ist somit in der Lage, auf minimalste Helligkeitsänderungen zu reagieren, wobei die Belichtung gewissermaßen stufenlos konstant gehalten wird.

Chromatische Adaption

Die Sinneszellen auf der Netzhaut des menschlichen Auges sind auch zur Wahrnehmung unterschiedlicher Spektralbereiche des Lichts geeignet. Die Bandbreite reicht dabei von etwa 380 nm bis über 760 nm. Die Verarbeitung der Farbinformationen geschieht weitgehend stufenlos. Die Sinneszellen sind in der Lage, mit einer gewissen Zeitverzögerung ihre Lichtempfindlichkeit zu ändern, wobei es immer einen Ausgleich hin zu einer möglichst ausgewogenen Wahrnehmung aller Lichtfrequenzen bei einer ausgewogenen Belichtung gibt. Dieser Ausgleich braucht aber seine Zeit: Von der Kamera her kennen wir die automatische Einstellung auf ein möglichst ausgewogenes Frequenzspektrum als automatischen Weißabgleich. Beim menschlichen Auge kann ein Weißabgleich, chromatische Adaption genannt, bis zu einer halben Stunde dauern.

Stereo-3D in der Fotografie

Fotografen experimentierten schon in den Anfängen des Mediums mit dreidimensionalen Bildern: Schon um 1838 wurde mit Kameras gearbeitet, die in der Lage waren, zwei um den Augenabstand voneinander entfernte Bilder gleichzeitig auf eine Platte zu bannen. Diese konnte man dann in teils abenteuerlich anmutenden Apparaturen betrachten. Die Objektive der Kameras waren meist parallel angeordnet — heute spricht man bei solchen Setups von der Side-by-Side-Anordnung. Da der Objektabstand gegenüber dem seitlichen Abstand der Kameras zueinander relativ groß war, fielen Abbildungsfehler nicht besonders ins Gewicht. Außerdem hat das Auge bei der Betrachtung statischer Stereo-3D-Bilder genügend Zeit, sich auf die ungewohnte Situation einzustellen — daher verzeiht es Ungenauigkeiten in der Bildwiedergabe eher als beim Bewegtbild.

Unter bestimmten Aufnahmesituationen wird, in der modernen Stereo-3D-Aufnahmetechnik ganz bewusst ein größerer Abstand der Kameras zueinander gewählt, um den Stereo-3D-Effekt über die dadurch verbreiterte Stereobasis zu verstärken. Zu interessanten Effekten führt dies beispielsweise bei Landschaftsaufnahmen. Sie bekommen eine ungewohnte Plastizität, wirken dadurch jedoch auch leicht künstlich.

Eckpunkte eines Stereo-3D-Kamera-Setups

Will man dreidimensionale Bewegtbilder aufnehmen, speichern und wiedergeben, so ist es erforderlich, die erwähnten wahrnehmungsphysiologischen Eigenheiten des menschlichen Sehens möglichst detailgetreu nachzubilden. Stereo-3D-Bilder werden nur dann als natürlich empfunden, wenn das Gehirn die Bildinformationen auch wieder in einen einwandfreien räumlichen Zusammenhang bringen kann. Dies stellt sowohl an die Bildaufnahmeverfahren wie auch an die Verarbeitung und Ausspielung erhebliche Anforderungen:

• Das Kamera-Setup muss es erlauben, bei Änderungen der Kameraposition zum Objekt auch die Abbildungsparameter Schärfe, Konvergenz und gegebenenfalls Brennweite der beiden Linsensysteme absolut synchron zueinander zu verändern. Will man zwei dreidimensionale Bilder in der Postproduktion miteinander mischen oder ineinander überblenden, sollte das möglichst auf der gleichen Schärfeebene geschehen, weil dann die gleichen Konvergenzpunkte vorliegen. Vor dem Mischen muss deshalb dem Bild eine Tiefeninformation zugeordnet werden, weshalb spezielle 3D-Postproduktionssysteme in der Lage sind, dem Bild ein Tiefen-Layer zuzuordnen. Damit lässt sich der Konvergenzpunkt der Bilder dann festlegen.

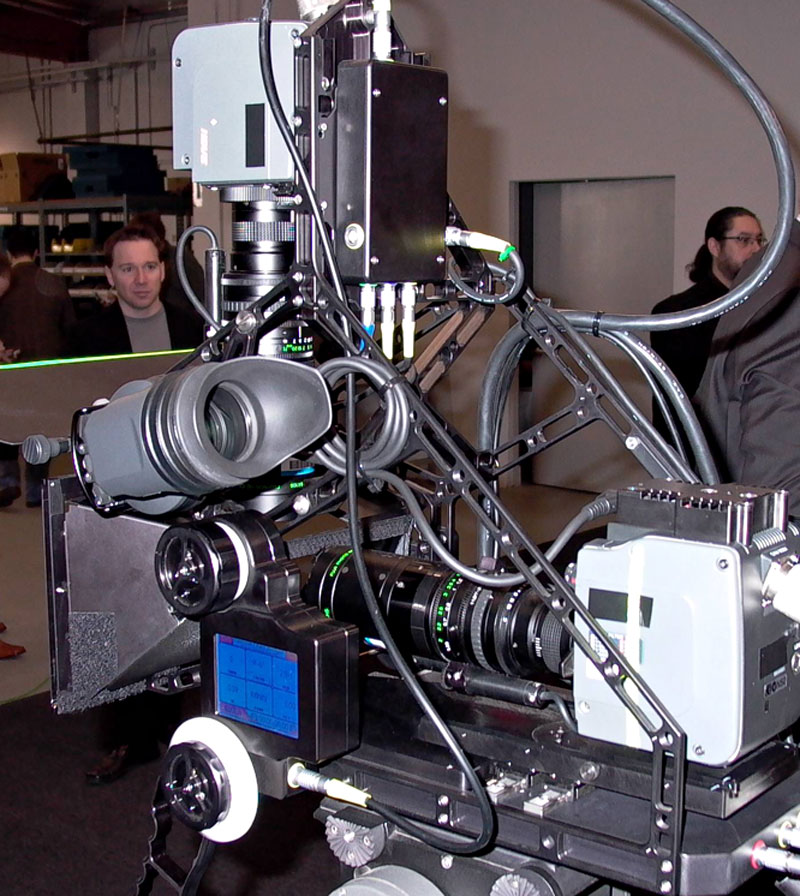

• Ein weiterer wichtiger Punkt, den man berücksichtigen sollte, ist die Ausrichtung der optischen Achsen der beiden Kameras zueinander. Um es plakativ zu formulieren: Sind die Achsen mangelhaft ausgerichtet, wird es dem Kinobesucher schwindlig und/oder schlecht, wenn er sich den Stereo-3D-Film ansieht. Der Grund dafür: Die Erzeugung sich deckender Bilder im Sehzentrum des Gehirns ist nur dann gewährleistet, wenn sich die optischen Achsen der beiden Objektive stets im Betrachtungspunkt schneiden. Handelsübliche Objektive, insbesondere Zoomobjektive, weisen jedoch häufig einen optischen Versatz auf, der sich bei Veränderung eines Linsenparameters (Brennweite oder Fokus) ebenfalls verändert, das Bild wandert oder verschiebt sich dann.

Bei feststehender Kamera bemerkt der Zuschauer selbst ein leichtes Wandern des Bildes um die optische Achse, das daraus resultiert, dass die Bildachse des Objektivs sich relativ zur theoretischen Mittelachse bewegt. Dieser Kollimationsfehler führt dazu, dass die Objektive »schielen«. Wenn dieser Effekt nicht korrigiert wird, dann pflanzt er sich durch die gesamte Aufnahmekette fort und wird bei der Betrachtung sichtbar. Da der Betrachter diesen Fehler ebenfalls nicht korrigieren kann (das Bild existiert ja tatsächlich so und die Augen scannen während der Sakkaden automatisch auf dieselben Bildteile), registriert das Gehirn ebenfalls ein Schielen der Augen. Die Bildteile passen nicht aufeinander, und in der Folge wird es dem Zuschauer schlecht. Die Kollimationsfehler werden beispielsweise beim 3D-Rig des Herstellers 3ality automatisch anhand von vorher eingemessenen Linsenparametern mittels Servomotoren korrigiert.

Prinzipiell sind 3D-Aufnahmen sowohl mit Film, wie auch mit elektronischen Aufnahmeverfahren möglich. Einen einschränkenden Faktor bilden die teilweise erheblichen mechanischen Abmessungen der Aufnahmesysteme aus dem professionellen Sektor: Man kann diese Kameras und Objektive gar nicht nah genug nebeneinander Platzieren, um den richten Interokularabstand und die richtige Konvergenz zu erreichen. Es muss deshalb in die Trickkiste gegriffen werden.

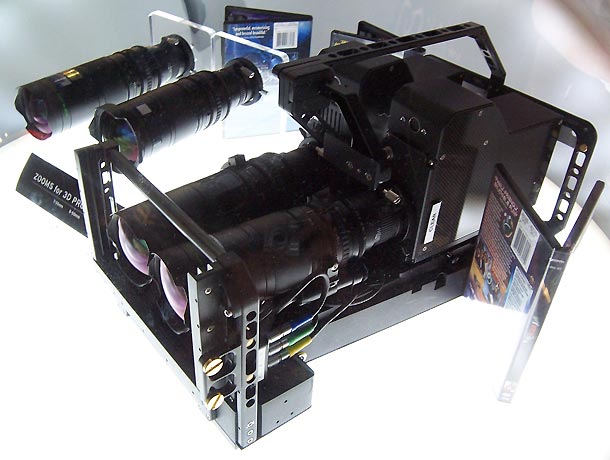

• Zunächst ist es erforderlich, die Kameras so zueinander zu positionieren, dass der natürliche Interokularabstand durch die räumliche Distanz zwischen den Bildaufnahmesensoren erreicht wird. Das stößt in der Praxis auf geometrische Probleme, da übliche Kameras in der Regel breiter sind, sodass sich aufgrund der Baumaße der menschliche Interokularabstand, nicht durch einfaches Nebeneinanderstellen der Kameras realisieren lässt. Will man es trotzdem schaffen, beide Bildsensoren auf einer Ebene anordnen, sind Modifikationen an den verwendeten Geräten oder vollständige Spezialkonstruktionen erforderlich. Solche Side-by-Side angeordnete Kameras findet man beispielsweise beim Stereo-3D-Pionier Pace aus Burbank. Handelsübliche Kameras und Objektive werden dort zerlegt, auf Interokularabstand zusammengerückt und mit einem neuen Gehäuse versehen.

Auch die im professionellen Bereich anzutreffenden Objektive haben eher selten einen Durchmesser, der unter den erforderlichen sechs bis acht Zentimetern liegt. Bei Pace schreckt man für die parallele Anordnung der Kameras für einzelne Anwendungen auch nicht davor zurück, einmal einen Satz Objektive mit der Säge in der Breite zu reduzieren. Die parallele Anordnung ist dann erforderlich, wenn für das Setup wenig Platz zur Verfügung steht, etwa bei einer Unterwasserkamera.

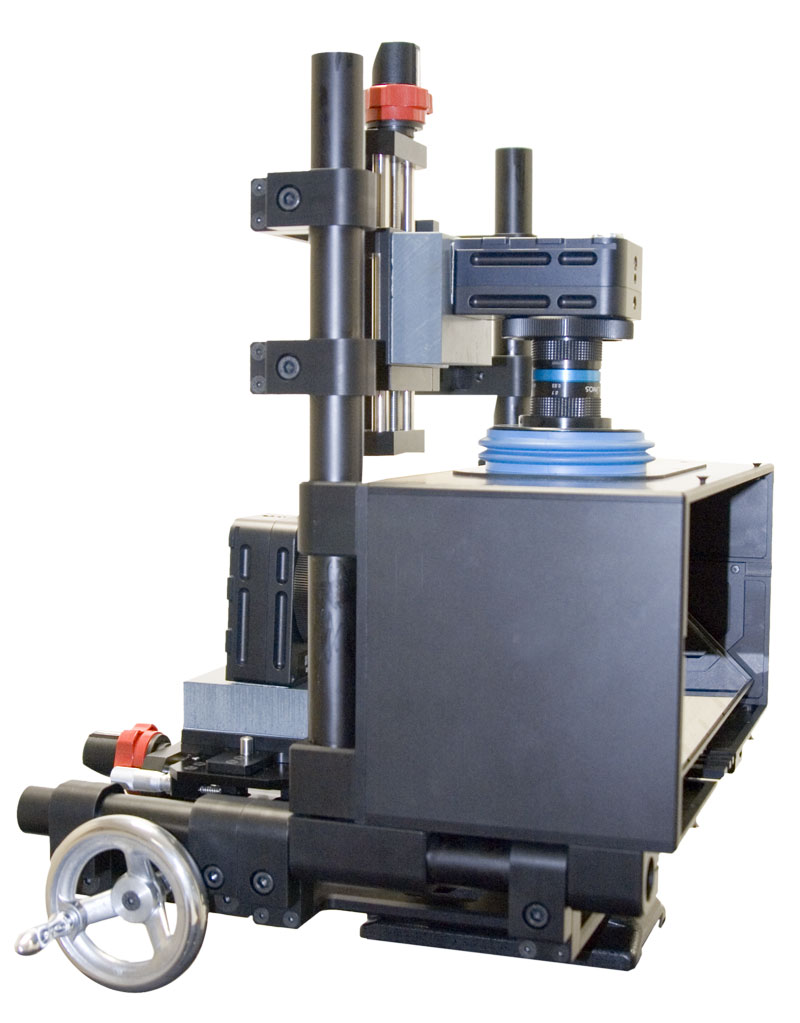

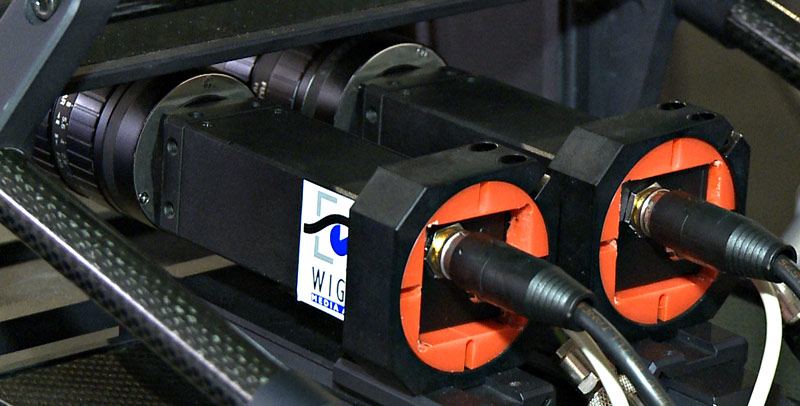

Die überwiegende Anzahl der Systeme arbeitet heute jedoch mit einer anderen Kameraanordnung. Die Kameras werden im rechten Winkel zueinander montiert, zwischen den Objektiven ist ein halbdurchlässiger Spiegel im 45-Grad-Winkel angeordnet. Mit dieser Montageart ist es möglich, den Interokularabstand selbst mit großen, sperrigen Kameras korrekt einzustellen und die Kameras auf die gleiche Bildebene einzustellen. Die Hersteller P+S Technik, Pace und 3ality Systems bieten solche Systeme an. Prinzipiell sind diese Systeme ähnlich aufgebaut, dennoch unterscheiden sie sich in der Ausstattung und in den technischen Möglichkeiten.

• Weiterhin muss das Stereo-3D-Rig eine Möglichkeit bieten, die Konvergenz für einen bestimmten Objektabstand einzustellen. Dies geschieht per Hand oder — wie bei Pace oder 3ality Systems — servomotorisch.

• Um ein Stereo-3D-Rig optimal nutzen zu können, ist es erforderlich, die Objektiveinstellungen synchron verändern zu können. Allerdings weisen selbst Objektive der gleichen Bauserie teilweise recht große Toleranzen auf. Diese führt zum schon beschriebenen Wandern der beiden Bilder und kann bei der Aufnahme nicht manuell korrigiert werden. Nur eine schnelle, intelligente servomotorische Ansteuerung der Linsen kann die Eigenheiten der verwendeten Objektive beim Zoomen oder Bewegen der Kamera ausgleichen.

Fazit

Es ist keineswegs trivial, ein gut funktionierendes Stereo-3D-Rig zu entwickeln, denn viele Rahmenbedingungen beeinflussen letztlich die Qualität des Setups. Außerdem verlangen Stereo-3D-Rigs auch von 3D-Operatoren und Kameraleuten viel Fachkenntnis, denn sie müssen viele Eckdaten beim Stereo-3D-Dreh berücksichtigen, wenn das Ergebnis stimmen soll.

Weitere Infos zum Thema bei film-tv-video.de

Infos über aktuell verfügbare Stereo-3D-Rigs finden Sie hier. Ein Videoreport über das Stereo-3D-Rig von P+S Technik steht hier bereit.

Einen aktuellen Messekommentar zum Thema Stereo-3D können Sie hier nachlesen, einen älteren finden Sie hier.

Einen Videoreport von der IBC2008 zum Thema Live-Stereo-3D können sie hier sehen.

Ein Gespräch mit Matt Cowen, Chief Scientific Officer des kanadischen Unternehmens Real D, steht hier bereit.

Wie die Games-Welt mit Stereo-3D ins Kino kommen will, erklärt ein Interview zu diesem Thema.

Infos zur Projektion fasst ein weiterer Artikel zusammen, ergänzende Infos hierzu bietet eine weitere Meldung.

Welche Chancen Quantel dem Thema Stereo-3D einräumt, können sie in einem Videoreport sehen.