4K, Ultra HD und noch viel mehr

Das Schlagwort 4K ist derzeit in der Branche allgegenwärtig. Doch nicht immer meinen wir dasselbe, wenn wir über 4K reden. Zwar leitet sich der Begriff nur von der Auflösung ab, aber in der Praxis sind mit 4K noch zahlreiche weitere Aspekte thematisch verbunden, wie etwa ein höherer Dynamikumfang, ein erweiterter Farbraum und zusätzliche Frameraten – die allesamt gegenüber der höheren Auflösung nicht unter den Tisch fallen sollten, wenn es nach dem Willen vieler Experten geht. Ein Überblick.

Wie bei jeder neuen Technologie gibt es derzeit beim Thema 4K Befürworter und Gegner. Diskussionen kann man aber nur dann sinnvoll führen, wenn man sich auf eine Terminologie und ein paar grundlegende Fakten geeinigt hat.

4K oder 4k?

Eher wissenschaftlich angehauchte Diskutanten machen sich gern mal darüber lustig, dass viele Branchenteilnehmer ja 4K nicht mal richtig schreiben könnten. Korrekt muss es schließlich 4k heißen, weil es ja um Auflösungen in der Größenordnung von 4.000 Bildpunkten geht und im Internationalen Einheitensystem (SI) das kleine k als Abkürzung für die Vorsilbe »Kilo« festgelegt ist, was wiederum für Tausend steht. Das große K hingegen wird als Einheitensymbol für Kelvin verwendet.

Daraus lässt sich dann noch der etwas lahme Scherz zimmern, dass 4K ja einer Temperatur von -269,15 Grad Celsius entspreche. Ach, was haben wir gelacht …

Ausgehend von der Überlegung, dass ohnehin alle in der Branche zumindest prinzipiell wissen, was mit 4K gemeint ist, verwenden wir in dieser Publikation und den damit verbundenen Artikeln, sowie generell auf der Website film-tv-video.de die zwar im Grunde falsche, aber in der Branche sehr weit verbreitete Schreibweise 4K — und salutieren gleichzeitig all jenen, die es wissenschaftlich genau nehmen.

4K oder UHD?

Müsste man nicht sogar von UHD oder Ultra HD sprechen, anstatt von 4K? Auch hier unterscheiden sich die wissenschaftliche Sicht und der Sprachgebrauch. Ohne auf die Feinheiten eingehen zu wollen, ist im folgenden die in in dieser Publikation und den damit verbundenen Artikeln, sowie generell auf der Website film-tv-video.de umgesetzte Verwendung erklärt.

Wir nutzen »4K« als Oberbegriff für das Arbeiten mit Auflösungen in der Größenordnung von 4.000 horizontalen Bildpunkten. Außerdem steht der Begriff 4K für einen stärkeren Produktionsbezug.

UHD hingegen bezieht sich unserer Auffassung nach stärker auf die Ausstrahlung. So sind in der Definition von UHD unter anderem auch Audioparameter, Datenraten und Codecs festgelegt, die so in der Produktion keine große Rolle spielen, sondern frühestens in der Postproduktion oder im Mastering zum Tragen kommen. Der Begriff Ultra HD wird zudem von der Unterhaltungsindustrie zunehmend genutzt, um die Übertragung und den Empfang von TV-Signalen in 4K-Auflösung zu kennzeichnen.

4- und 8K-Auflösungen

3.840 x 2.160

Wer eher von der Videoseite kommt, der definiert als 4K meist die Verdoppelung der horizontalen und vertikalen HD-Auflösung: Aus dem Raster 1.920 x 1.080 wird also 3.840 x 2.160. Das sind dann viermal so viele Bildpunkte wie bei »Full HD«, weshalb des öfteren auch mal über Quad Full HD gesprochen wird, kürzer als QFHD bezeichnet.

Die 3.840 horizontalen Bildpunkte dieses Formats werden aber meistens auch großzügig auf 4.000, also 4K aufgerundet.

Auf diesem Raster basiert auch UHD 1, also der für die Ausstrahlung von 4K-Fernsehprogrammen gedachte Formatstandard.

4.096 x 2.160

Eher aus dem Filmbereich kommen andere 4K-Definitionen. Das hat letztlich (auch) historische Gründe, die noch aus der Filmabtastung herrühren (siehe Lexikon): Fakt ist, dass im Scanning- und Filmabtasterbereich der Begriff 4K für ganz unterschiedliche Raster verwendet wurde, die aus dem jeweils genutzten Filmfenster resultierten. Bei den Digitalkameras kann aber 4.096 x 2.160 als weit verbreitet gelten.

7.680 x 4.320

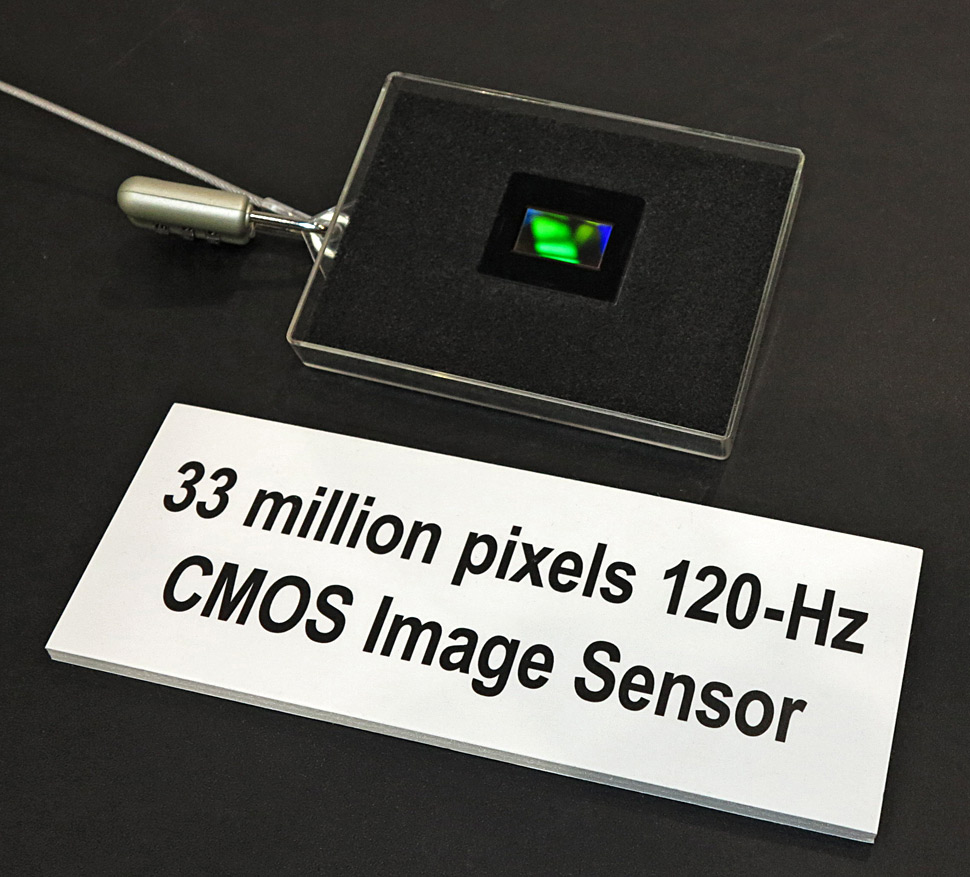

Verdoppelt man die Zeilen- und Linienzahl von QFHD/UHD 1 noch einmal, dann ergibt sich das Raster 7.680 x 4.320 – was auch unter dem Oberbegriff UHD 2 zusammengefasst wird. Dieses Format verwendet also die horizontal und vertikal vierfache Zahl an Bildpunkten des HD-Rasters 1.920 x 1.080. Dieses Verfahren wurde maßgeblich unter der Ägide des japanischen Staatsfernsehens NHK entwickelt, wird von diesem Sender aber nicht als Ultra HD bezeichnet, sondern als Super Hi-Vision (mehr dazu in einem früheren Artikel). Der Ton soll dabei als 22.2-Kanal-Ton übertragen werden. Zudem umfasst die Definition Bildraten von bis zu 120 fps. (Mit Sinn oder Unsinn von 8K im TV-Bereich befasst sich ein früher erschienener Kommentar zu diesem Thema.)

Weitere Faktoren

Wenn aktuell höhere Auflösungen diskutiert werden, geht es dabei meist um die Auflösung im Zusammenspiel mit 8-Bit-Signalverarbeitung und dem BT.709-Farbraum. Einige Hersteller sehen darin einen ausreichend großen technologischen Schritt, nach dem Motto: Erstmal 4K-Auflösung, den Rest schieben wir dann in weiteren Schritten nach.

Derweil führten und führen aber Forschungseinrichtungen, Standardisierungsgremien und Verbände teilweise Versuche durch, deren Ergebnisse nahelegen, dass es sinnvoll wäre, nicht nur die räumliche Auflösung, sondern auch die zeitliche Auflösung zu verbessern, also die Framerate zu erhöhen.

Weitere Faktoren wie etwa Dynamikverbesserungen, hin in Richtung HDR, werden ebenfalls diskutiert.

Weder die Herstellerseite, noch die Gremien sprechen aber derzeit mit einer Stimme, sondern es wird heftig darüber gestritten, ob und welche anderen Faktoren berücksichtigt werden sollten, wenn es um die Verbesserung der Bildqualität geht. Exemplarisch sei hier Franz Kraus von Arri zitiert (Interview), der sagt: »Die Bildgüte einer Kamera ist nicht in K zu messen. Es gehören viel mehr Aspekte dazu, ein gutes Bild zu erzeugen. Die ganze K-Diskussion steht für eine verkürzte Sichtweise, die dem Thema absolut nicht gerecht wird.«

Fakt ist aber, dass im Markt immer mehr 4K-Kameras und -Displays verfügbar werden und hier möglicherweise durch die Marktdynamik Fakten geschaffen werden, bevor man sich auf eine in alle Feinheiten reichende Definition von 4K/UHD geeinigt hat.

Farbraum

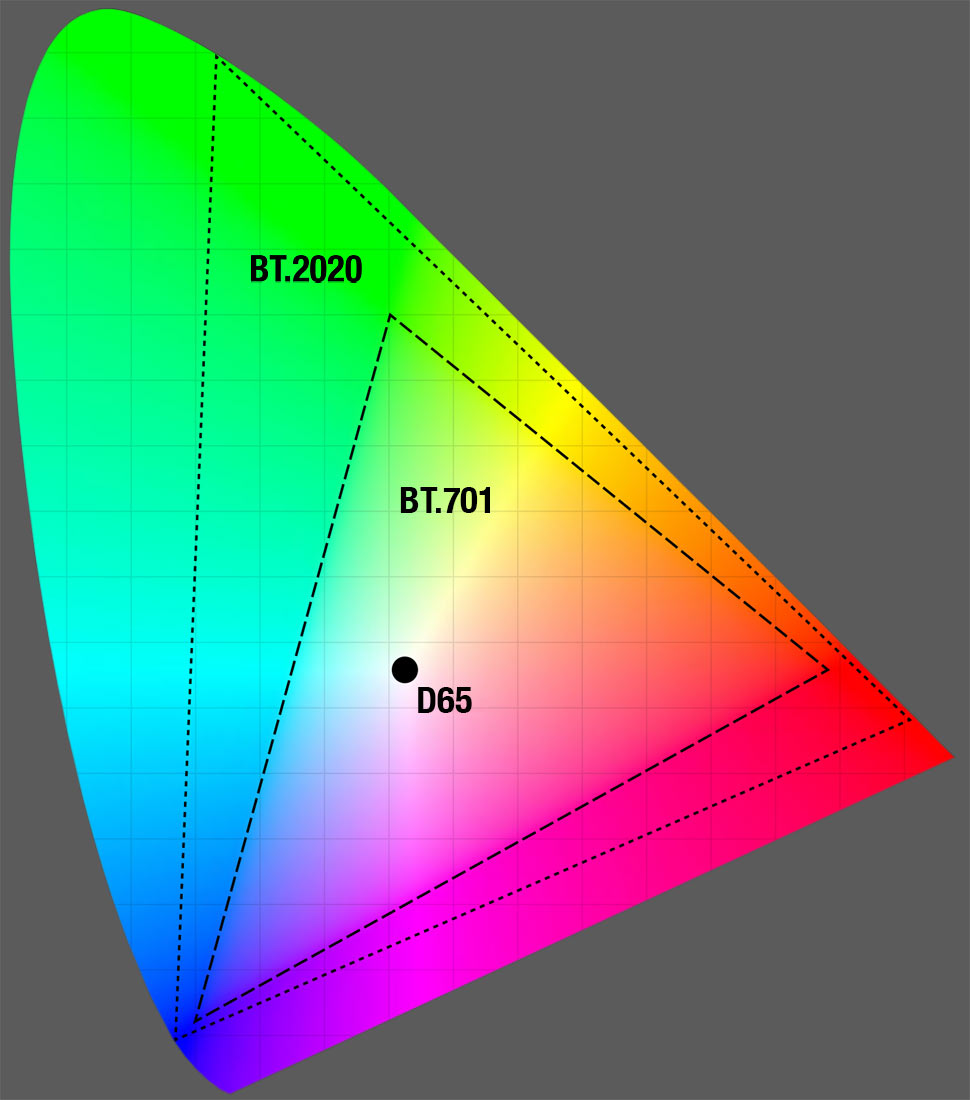

Wenn es nach dem Willen von Standardisierungsgremien wie etwa der EBU geht, soll 4K auch mit einem größeren Farbraum gemäß BT.2020 arbeiten, der über das hinausgeht, was etwa im HD-Bereich mit dem Farbraum BT.709 und im D-Cinema mit P3 RGB definiert ist. Ein erweiterter Farbraum würde das Farbspektrum, das auch in der Natur vorkommt, noch deutlich realistischer abbilden.

Mit dem Aufkommen der Raw-Aufzeichnung bei Kameras wird dies aber immer weniger zu einem Thema der Originalaufnahme, sondern immer mehr zu einem davon abgekoppelten Thema der Postproduction, des Display-Bereichs und der Ausstrahlung.

Framerate

Seit auch die Bildwiedergabe weitgehend digitalisiert ist, verstärkt sich ein Trend hin zur Aufnahme und Wiedergabe von Bewegtbildern mit höheren Bildraten, auf englisch: High Frame Rate (HFR). Statt der im Kino üblichen 24 fps, wird dann beispielsweise mit der doppelten Bildrate von 48 fps gearbeitet. Einer der ersten Regisseure, die HFR dem breiteren Kinopublikum bekannt machten, ist Peter Jackson. Dessen bisher zu 2/3 ausgerollte Hobbit-Trilogie wird in entsprechenden Kinos in Stereo-3D mit 48 fps gezeigt. Außerdem setzte Jackson das neue Audiosystem Dolby Atmos oben drauf. Man kann sich also zum Preis eines Kinotickets in einem entsprechend ausgestatteten Kino selbst einen Eindruck verschaffen, was das in der Praxis bedeutet.

Die Wiedergabe von Filmen mit 48 Vollbildern pro Sekunde hat den Vorteil, dass das Bild weniger flimmert und plastischer wirkt. Wenn auch mit 48 fps aufgenommen wurde, dann steigt auch die Bewegungs- und Detailauflösung. Dieser Effekt wurde schon vor vielen Jahren bei speziellen Filmprojektions-Verfahren genutzt, die im Special-Venue-Bereich eingesetzt wurden, so etwa beim von Douglas Trumbull entwickelten Showscan-Verfahren.

HDR, Dynamikumfang

Bilder mit einem höheren Dynamikumfang und höherer Spitzenleuchtdichte werden von Zuschauern in der Regel als schärfer eingestuft als »normale« Bilder – auch wenn die räumliche Auflösung gleich bleibt, also wenn gleich viele K oder Bildpunkte dargestellt werden.

In Zeiten von HDR-Smartphone-Apps und HDR-Fotoapparaten kann man diesen Effekt leicht selbst nachprüfen: Meist wird bei HDR-Apps und auch bei digitalen Fotoapparaten zwei mal belichtet, wobei beim einen Bild die hellen und beim anderen die dunklen Bereiche betont werden. Dann werden die beiden Bilder zusammengerechnet und es entsteht ein neues Bild, das sowohl die hellen, wie auch die dunklen Bereiche sehr gut abbildet und einen sehr hohen Kontrastumfang bietet.

Immersive Audio

Die neuen Formate sollen nicht nur beim Bild, sondern auch beim Ton für neue Seh- und Hörerlebnisse sorgen. »Immersive Audio« ist eines der Schlagwörter, das in diesem Zusammenhang oft zu hören ist. Dahinter verbirgt sich die Idee, den Ton – etwa eines Spielfilms – in der Wiedergabe noch eindrucksvoller und realistischer zu gestalten. Dabei wird üblicherweise mit mehreren Audiokanälen gearbeitet. Die bisher extremste Ausprägung ist NHKs Super Hi-Vision mit 22.2-Kanal-Ton – was im typischen Wohnzimmer schwierig umzusetzen sein dürfte …

Aber natürlich gibt es auch praktikablere Ansätze für immersive Audio – was aber ohnehin insgesamt weniger ein Thema der Originalaufnahme, als der Postproduktion und Ausstrahlung darstellt.

Datenraten, Schnittstellen

Nimmt man Bilder mit einer Auflösung von 3.840 x 2.160 Bildpunkten mit 50 Vollbildern in 4:2:2 und 10 Bit auf, kommt man dabei auf eine Datenrate von rund 8,3 GBit/s – was etwa 8fach so viel Daten sind, wie bei HD in 1080p50. Erhöht man die Framerate auf 120 fps, kommt man auf rund 19,9 Gbit/s – und somit auf nahezu die 20fache Datenmenge von 1080p50.

Noch größer wird die Datenmenge natürlich bei UHD-2 mit einer Auflösung von 7.680 x 4.320p mit 120 fps: Dann braucht es eine Schnittstelle, die rund 80 Gbit/s übertragen kann.

Aus heutiger Sicht sind das alles ziemlich hohe Anforderungen und passende, praktikable Schnittstellen dafür gibt es noch gar nicht. Letztlich ist es aber – wie schon damals bei der Einführung von HD – nur eine Frage der Zeit, bis es hier Lösungen geben wird.

Mit HDMI 2.0 etwa ist schon jetzt eine Schnittstelle angekündigt, die eine maximale Bandbreite von 18 Gbit/s bietet. Man wird also Material der Auflösung 4.096 x 2.160 und der Framerate 60p über diese Schnittstelle übertragen können.

Außerdem besteht natürlich auch die Möglichkeit, 4K-Aufnahmen file-basiert zu übertragen, oder über Schnittstellen für komprimierte Bildsignale – denn natürlich wird man auch im 4K-Bereich nicht ausschließlich mit unkomprimierten Bildern arbeiten, sondern mit Kompressionsalgorithmen dafür sorgen, dass man mit handlicheren Datenraten operieren kann.

HEVC

HEVC ist ein Video-Kompressions- und Kodierverfahren für die Distribution von 4K-Aufnahmen. HEVC trug in der Entwicklungsphase teilweise auch den Spitznamen H.265 oder wurde als MPEG-H Teil 2 bezeichnet. Im Spitznamen H.265 sollte zum Ausdruck kommen, dass es hier um den Nachfolger von H.264 geht. Die offizielle Bezeichnung lautet nun aber HEVC, was für High Efficiency Video Codec oder High Efficiency Video Coding steht.

Ziel bei der Entwicklung war es, eine im Vergleich zu H.264 doppelt so starke Kompression bei gleicher Bildqualität zu erreichen. Außerdem wurden bei HEVC die Rastergrenzen erweitert: Es sind Bildraster von 320 x 240 bis zu 8.192 x 4.320 Bildpunkten definiert.

Wie die anderen Codecs/Kompressionsverfahren auch, ist HEVC in verschiedene Profile, Ebenen und Levels untergliedert, je nachdem, wie hoch einerseits die Sampling- und Bildrate und wie fein das Raster sein soll, mit denen der Codec arbeitet und wie hoch andererseits die Datenrate sein soll, die der Codec am Ende ausspuckt.

HEVC soll als Codec für die Ausstrahlung in Ultra HD genutzt werden. Aktuell kämpft die Industrie allerdings noch damit, dass die Chips für HEVC-Codierung noch nicht in großen Stückzahlen zur Verfügung stehen. Es gibt zwar Prototypen, aber Decoder werden wohl erst 2015 in größerem Umfang verfügbar werden.

Derzeit wird allgemein davon ausgegangen, dass HEVC in der Originalaufnahme keine Rolle spielen wird. Hier werden wohl XAVC, AVC-Ultra, ProRes und andere Kompressionsverfahren eingesetzt.

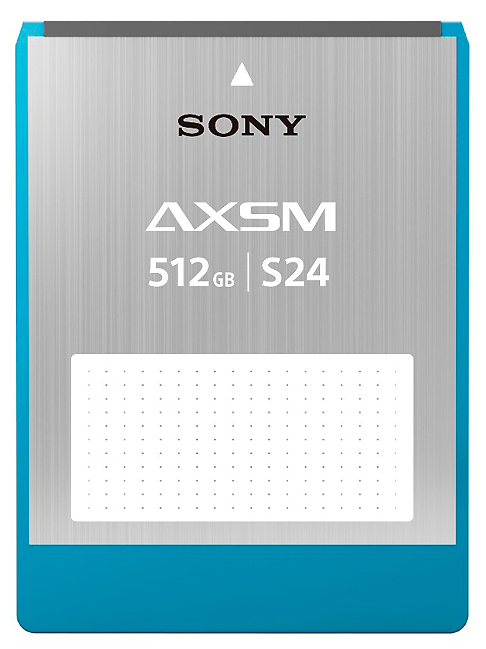

XAVC, HDCAM SR

Mit XAVC stellte Sony einen Codec vor, den das Unternehmen in verschiedenen Ausprägungen oder Profilen nutzen will. XAVC ist eine Sonderform von MPEG-4, Part 10.

XAVC unterstützt Auflösungen bis 4K (4.096 x 2.160, 3.840 x 2.160) und arbeitet mit 12, 10 oder 8 Bit Farbtiefe und 4:4:4, 4:2:2 oder 4:2:0. MXF-Wrapping kann genutzt werden. Die Datenkompression erfolgt nicht auf Basis eines MPEG-2-Verfahrens, sondern mittels MPEG-4/AVC — diesen Codec nutzt Sony auch bisher schon im unteren Profibereich, etwa bei NXCAM, dort aber mit viel niedrigerer Datenrate und als Long-GoP-Verfahren (AVCHD).

Die 4K-Raster werden in XAVC derzeit mit 4:2:2 und 10 Bit per Intraframe-Kodierung komprimiert, die Datenrate kann bis zu 600 Mbps betragen, die Bildrate 23,98 bis 59,94 Hz in progressiver Bildfolge.

Werden XAVC und AVC-Ultra, die ja ähnliche Zielanwendungen haben, kompatibel sein? Bedingt: Sony sagt, dass man mit XAVC durch die Unterstützung des sogenannten Level 5.2 in der Lage sei, AVC-Intra-Material wiederzugeben, das von Panasonic-Geräten kodiert wurde.

Am Top-End der Codecs/Formate sieht Sony aber bis auf weiteres MPEG-4 SStP, besser bekannt als HDCAM SR und SR Master. Dieser Codec verpackt die Daten in einen MXF-OP-1a-Wrapper. Er komprimiert die Daten und stellt 220, 440 oder 880 Mbps als Datenrate zur Verfügung, Bildsignale können damit in Form von 4:2:2 mit 10 Bit oder als RGB mit 10 oder 12 Bit Quantisierung verarbeitet werden – zusammen mit bis zu 16 Audiokanälen.

AVC-Ultra

AVC-Ultra ist eine Codec-Familie von Panasonic, die einzelne Codecs für verschiedene Zwecke bereitstellt. Alle nutzen die gleiche Grundtechnologie, aber erzeugen Material in verschiedenen Qualitätsstufen.

Panasonic vermarktet AVC-Ultra als Codec-Familie, die einerseits den AVC-Intra-Codec einschließt, aber andererseits auch Codecs für 1080p und 4K umfasst, sowie etwa auch Proxy-Auflösungen.

Für die komprimierte 4K-Aufzeichnung ist AVC-Intra 444 konzipiert. Panasonic zeigte schon verschiedentlich damit kodiertes 4K-Footage mit 400 Mbps.

4K wird kommen

Angesichts der Fülle der technischen Parameter, die es für 4K und auch schon für Auflösungen jenseits davon gibt, kann man ablesen, dass 4K auf einem guten Weg ist. Sicher gibt es noch viele Aspekte, die gelöst werden müssen: auf technischer Seite wie auf Seiten der Sender, die vielerorts noch nicht einmal im HD-Zeitalter angekommen sind. Doch die 4K-Technik wird kommen, ob man das gut findet oder nicht.

Es gibt noch einen weiteren Aspekt, der für eine relativ rasche Etablierung von 4K spricht: Viele Hersteller haben in den vergangenen Jahren Technologien und Chipsets für Produkte entwickelt, die den Stereo-3D-Markt bedienen sollten, der aber mittlerweile wieder auf Nischengröße geschrumpft ist. Aber von den hier realisierten höheren Bandbreiten und Datenraten kann nun 4K profitieren

Auch auf der Anwenderseite wurde teilweise schon in Speicher und Bandbreite für Stereo-3D investiert, so dass auch hier der Datenschock von 4K milder ausfallen könnte, als man zunächst denken könnte. So gesehen war der Stereo-3D-Hype vielleicht doch zu irgendetwas nütze.

Vielleicht kann man es so zusammenfassen: Viele in der Branche sind sich darin einig, dass 4K / Ultra HD weitaus größere Chancen für eine hohe Marktdurchdringung aufweist, als es Stereo-3D je hatte.

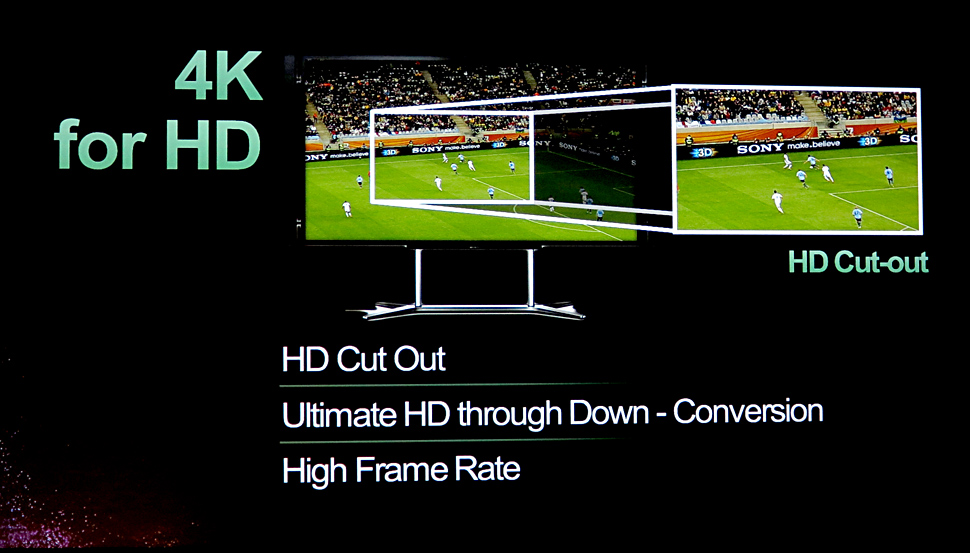

Ein Weg könnte dabei darin bestehen, dass Technologien, die für den Kinobereich entwickelt wurden, nun zunehmend den TV-Markt infiltrieren: So werden etwa auch im TV-Bereich immer öfter Kameras mit größeren Sensoren eingesetzt (SLS-Kameras) und viele davon bieten schon deutlich höhere Auflösungen als HD. Setzt man einen entsprechenden Workflow mit einer Funktionalität dahinter, wie sie derzeit mit Schlagworten wie 4K-for-TV und 4K-for-HD oder auch mit HD-Cut-Out oder 4K-Zooming und 4K-Stitching umschrieben wird, dann kann man jetzt schon 4K-Equipment sinnvoll für die TV-Produktion einsetzen, auch wenn nur in HD ausgestrahlt wird.

Dahinter stecken auch Erfahrungen aus der Einführung von HD: Irgendwann muss man ja mal anfangen, wenn das Ganze was werden soll. Die meisten 4K-für-TV-Produktionen haben derzeit noch Testcharakter. Im Kinobereich ist 4K keineswegs mehr exotisch und die Zahl derjenigen, die den Einsatz von 4K im TV-Bereich zumindest auf der Produktionsseite testen, wächst rasch an. So kann man wohl davon ausgehen, dass »4K-für-HD« eines der Einfallstore für diese Technologie sein wird.

Empfehlungen der Redaktion:

25.02.2014 – »4K braucht kein Mensch!«

22.02.2014 – Confed Cup: Fußball in 4K — als Test für die WM

27.02.2014 – 4K für HD: Asiendreh von TVN

20.02.2014 – 4K-Zooming beim Super Bowl

07.03.2014 – Kunst in 4K: Getanzte Bilder

14.02.2014 – 4K bei Top-Liga-Fußballspiel in den Niederlanden

12.02.2014 – Mit 4K aus der Werbe- in die Fernsehwelt

12.11.2013 – Peter Gabriel: Tour in 4K

27.02.2014 – »War Horse« live auf der Kinoleinwand