Formatübersicht 2009: Die Büchse der Pandora

Die aktualisierte und erweitere Version der Formatübersicht von film-tv-video.de bietet neben Informationen zu allen aktuellen, relevanten Vidoeformaten auch Infos zu Speichermedien, alternativen Aufnahmeverfahren und Basics zum Thema Raw-Daten. Neben der kürzeren Online-Version dieses Artikels steht auch eine längere, mit Tabellen angereicherte PDF-Version am Textende zum Download bereit.

Übersichtlicher ist die Videowelt in den vergangenen Jahren ganz sicher nicht geworden: Immer schneller werden neue Techniken in den Markt getragen, immer kürzer werden die Produktzyklen. Die digitale Bildaufnahme spaltet sich zunehmend weiter auf: Es werden nicht nur permanent neue Verfahren entwickelt, wie man Bilder kleinrechnen und aufzeichnen kann, sondern es stehen heute auch mehr unterschiedliche Speichermedien zur Verfügung. So ergibt sich ein wahrer Dschungel aus Kodierverfahren (Codecs), Dateitypen (File-Formaten) und Speichermedien.

Dabei herrschen teilweise so chaotische Zustände, dass den Anwendern mitunter etliches Fachwissen abverlangt wird, wenn sie nicht Schiffbruch erleiden wollen.

Ein Beispiel: HDV-Aufnahmen gibt es mittlerweile in so vielen Spielarten, dass man keineswegs mehr sicher sein kann, dass sich diese auch mit jedem HDV-Recorder abspielen lassen — das Gegenteil ist der Fall. HDV-Aufnahmen sind nämlich mit 720 Zeilen und progressiver Bildfolge, aber auch mit 1080 Zeilen und Halbbildaufbau (interlaced) möglich. Außerdem stehen noch verschiedene Bildraten zur Verfügung und es gibt noch Varianten in der Audioaufzeichnung. Das alles gilt allein schon für die HDV-Aufzeichnung auf Videokassetten, es gibt aber auch HDV-Camcorder, die HDV-ähnliche digitale Bildfolgen alternativ auf Speicherkarten schreiben und natürlich kann man an viele Geräte auch einen portablen Diskrecorder anschließen.

Es hilft aber nichts mehr, über Versäumnisse, fehlende Logik und mangelnde Selbstkontrolle der Herstellerseite zu lamentieren: Die Büchse der Pandora ist geöffnet, die Lage stellt sich so dar, wie sie nun mal ist.

Wollte man alle Varianten der digitalen Videoaufzeichnung erfassen und darstellen, würde auch daraus ein schier undurchdringlicher Wust von Verästelungen entstehen, also ist auch hier Selbstbeschränkung gefragt: Die in diesem Artkel aufgestellte Formatübersicht listet die wichtigsten, gebräuchlichsten digitalen Systeme auf, die derzeit von engagierten Hobbyfilmern und Profis für Videoaufzeichnungen genutzt werden. Nicht enthalten sind reine Amateursysteme, wie sie etwa in Billig-Camcordern, Handys und Fotoapparaten verwendet werden.

Auch soll hier kein — letztlich sinnloser — akademischer Kampf um Worte geführt werden: Format, System, Standard — wie auch immer die Hersteller oder die Anwender ihr Videoverfahren nennen wollen, sie sollen damit glücklich werden. In diesem Artikel und dem angefügten PDF mit Tabellen gilt folgende Definition: In der Formattabelle sind die jeweiligen Eckdaten der Videoverarbeitung und der verwendete Codec aufgelistet. In einer separaten Tabelle sind die Eckdaten der Speichermedien aufgeführt. Weitere Abschnitte listen alternative Codecs und Aufzeichnungsmethoden auf. Der fortlaufende Text gibt allgemeine Infos, die sich schlecht in Tabellenform fassen lassen: Hintergründe und Besonderheiten, sowie Hinweise zu Kompatibilitätsfragen.

Welches Verfahren bietet die beste Bildqualität?

Plakative, simple Kriterien vereinfachen Entscheidungsprozesse: Aber genauso wenig wie der Fotoapparat mit den meisten Megapixels automatisch die besten Bilder macht, erreicht das Videosystem mit der höchsten Datenrate auch zwangsläufig die beste Bildqualität bei Videoaufnahmen.

Ganz sicher gibt die Datenrate eine erste Orientierung, aber in Zeiten ausgefuchster Kodiertechniken geht es auch darum, bei welchem Verfahren die verfügbare Datenrate am effektivsten genutzt wird. Hierüber allgemeingültige Aussagen zu treffen, ist aber sehr schwierig. Zum einen kann es tatsächlich vom einzelnen Motiv abhängen, wie gut ein bestimmtes Kodierverfahren arbeitet, zum anderen geht es hier immer weniger um Messwerte, als um den Bildeindruck, den der menschliche Betrachter gewinnt.

Als grobe Richtschnur und Tendenz kann aber gelten: Ein Signal mit einer Videodatenrate von 200 Mbps und einem Abtastverhältnis von 4:4:4 kann eine höhere Bildqualität aufzeichnen als eines mit 100 Mbps und 4:2:2, das wiederum mehr Qualität erlaubt als 4:2:0 mit 25 Mbps — aber es kommt eben auch auf den jeweils verwendeten Codec an.

Eine wichtige Rolle spielt auch das Raster, mit dem das jeweilige Verfahren arbeitet. Bei SD-Verfahren liegt dieses Raster fest, bei HD gibt es zunächst den Unterschied zwischen 720 und 1080 Zeilen, aber innerhalb des 1080-Zeilen-Lagers gibt es eine weitere Unterteilung: Bei HDV und XDCAM HD wird mit dem reduzierten Raster von 1.440 x 1.080 Bildpunkten gearbeitet, statt mit dem vollen Raster von 1.920 x 1.080, das etwa bei XDCAM HD 422 und HDCAM zum Einsatz kommt.

Weiteren Einfluss hat das Kompressionsverfahren. Die zur Datenreduzierung eingesetzten Codecs produzieren unterschiedlich gute Ergebnisse. Ziel ist es immer, die verfügbare Datenrate optimal zu nutzen und dabei eine möglichst hohe Bildqualität zu erreichen. Ein grundlegender Unterschied besteht darin, ob nur innerhalb eines Bildes komprimiert wird (Intraframe), oder ob mehrere aufeinander folgende Bilder gemeinsam verarbeitet werden (Interframe). Interframe-Verfahren arbeiten prinzipiell effektiver, erlauben also höhere Bildqualität bei einer vorgegebenen Datenrate als Intraframe-Verfahren. Allerdings wirken sich Bildfehler und Störungen bei Interframe-Verfahren immer auf eine ganze Bildfolge aus. Interframe-Verfahren erfordern zudem höhere Rechenleistung beim Kodieren und Dekodieren, sie sind dadurch für die Postproduktion ungünstiger. Apropos Postproduktion: Je intensiver Material bearbeitet werden soll (Compositing, Effekte, Grading), umso höher sollte die Datenrate sein und um so besser ist es, nur Intraframe-Kompression zu nutzen.

Die Bildfolgen, die von Interframe-Codecs erzeugt werden, nennt man Group of Pictures (<LEX>GoP</LEX>), deshalb werden Interframe-Verfahren oft auch als Long-GoP-Verfahren bezeichnet.

HD oder SD?

Klingt wie ein glasklarer Fall: Besonders wenn man das Material in der Zukunft wieder verwerten will, empfiehlt es sich, in HD zu drehen. Ob das Material aber tatsächlich das Potenzial zukünftiger Auswertungen in sich trägt, ist in vielen Fällen zweifelhaft. In der Praxis heißt es also sorgsam abwägen und es ist oft ratsam, erst einen Test zu fahren: Je nach gewünschtem Endergebnis und dem bis dahin nötigen Bearbeitungsweg, kann es nämlich auch heute noch durchaus sinnvoller sein, in SD zu arbeiten.

Ein Beispiel: Sie drehen in HDV, stellen aber dann fest, dass das Bearbeitungssystem gar kein HDV mit der von Ihnen gewählten Zeilenzahl verarbeiten kann. Dann wird schon beim Einspielen des Materials gewandelt — vielleicht sogar in SD — und es bleiben nur die Nachteile von HDV erhalten, wie etwa die geringere Bewegungsauflösung, die ein Long-GoP-Verfahren mit sich bringt oder die schlechtere Farbtrennung eines stark komprimierenden Verfahrens. Wenn Sie das Material dann im Lauf der Bearbeitung intensiv bearbeiten wollen und dabei noch mehrfach umkodieren müssen, etwa weil Sie Teile in einem Compositing-System verfeinern wollen, das wieder andere Dateiformate braucht und weil Sie am Ende eine DVD oder ein Web-Video brauchen, kann es durchaus passieren, dass Sie besser bedient sind, wenn Sie am Anfang in einem robusten SD-Verfahren aufzeichnen.

Raw-Basics

In einigen Bereichen der Bewegtbildaufnahme setzt sich die Idee durch, gar nicht mehr in einem Videoformat und unter Einsatz eines Video-Codecs aufzuzeichnen, sondern die digitalen Rohdaten der Kamera komprimiert oder unkomprimiert zu speichern und diese erst nachträglich in der Postproduktion in RGB-Bilder zu verwandeln. Der prinzipielle Vorteil liegt darin, dass die Kameraelektronik vereinfacht wird und für die nachträgliche Bildgestaltung mehr Spielraum bleibt. Der Nachteil liegt darin, dass man Raw-Daten bei der Aufnahme nicht so einfach ansehen und in puncto Qualität kontrollieren und überwachen kann — sowie in umständlicherem Handling und komplexeren, zeitaufwändigeren Abläufen in der Postproduktion mit vielen potenziellen Fehlerquellen und langen Renderzeiten.

Alle gängigen Bewegtbildsensoren erzeugen zunächst nur Schwarzweißbilder. Die Farbinformation wird erst durch verschiedene Filterverfahren gewonnen. Eines davon, das überwiegend bei Single-Sensor-Kameras angewendet wird, ist das nach seinem Erfinder benannte Bayering: Dabei wird den einzelnen lichtempfindlichen Bildpunkten auf dem Sensor ein festgelegtes Muster zugeordnet, das Bayer-Pattern. Die Hersteller können dabei relativ frei schalten und walten, wie sie Rot-, Grün- und Blauanteile aus dem auf den Sensor fallenden Licht filtern wollen.

Die Daten, die man mit einem solchen Sensor gewinnt, werden Raw-Daten genannt. Um aus diesen Daten ein korrektes Farbbild darstellen zu können, muss man bei der weiteren Bearbeitung das Muster kennen, das den Bildpunkten zugeordnet wurde und man muss wissen, wie die Daten zu gewichten sind. Das wird beim De-Bayering umgesetzt und ist eine Wissenschaft für sich: Der hierbei verwendete Algorithmus entscheidet über die Bildqualität mit, besonders was die Auflösung, die Schärfe, die Farbwiedergabe und die Kantendarstellung betrifft.

Das De-Bayering kann man direkt in der Kamera durchführen und dann ein aus den Raw-Daten gewonnenes Videosignal aufzeichnen. Alternativ dazu kann man die Raw-Daten speichern und das De-Bayering später, also in der Postproduktion durchführen.

Weitere Aufnahmeformate

Besonders im Consumer-Bereich gibt es zusätzlich zu den im weiteren aufgeführten Videoformaten viele weitere, die aber meist mit so geringen Bewegungsauflösungen oder Rastern arbeiten, dass sie für den professionellen Einsatz ungeeignet sind.

Auf großes Interesse stoßen jedoch in jüngerer Zeit digitale Spiegelreflexkameras (DSLR). Der Grund dafür liegt neben dem relativ günstigen Preis und der kompakten Bauform darin, dass diese Kameras als Single-Sensor-Geräte ein filmtypisches Schärfentiefeverhalten bieten und den Einsatz von Wechselobjektiven erlauben. Die derzeit populärste Kamera in diesem Segment, die EOS 5D Mark II von Canon, zeichnet mit 30 fps auf CF-Speicherkarten im Raster 1920 x 1080 progressive Bilder auf. Gespeichert werden sie als H.264-kodierte MOV-Dateien mit linearem PCM-Ton.

1080p30 als Aufnahmeformat verursacht im europäischen Raum in der Postproduktion etliche Komplikationen und erfordert die Transkodierung oder zumindest Bildratenänderung des Materials.

Quicktime und andere Wrapper

Eine Idee, um den Übergang zwischen Camcorder und Schnittsystem zu vereinfachen, hat JVC realisiert: Mit zwei neuen Camcordern dieses Herstellers kann im Quicktime-Format auf <LEX>SD-HC</LEX>-Speicherkarten aufgenommen werden. Die Daten können dann von Apples Schnitt-Software Final Cut Pro (FCP) direkt verarbeitet werden.

Quicktime fungiert dabei als Wrapper, also als Datenhülle für die Videodaten, die der Camcorder erzeugt. Der Camcorder schreibt in der höchsten Qualitätsstufe MPEG-2-Sequenzen in Long-GoP-Kodierung, die maximale Datenrate liegt bei 35 Mbps: Das entspricht exakt XDCAM EX, nur dass diese Daten eben nativ im Quicktime-Format gespeichert werden und dadurch direkt von FCP lesbar sind. Alternativ stehen 25 und 19 Mbps als Datenrate zur Verfügung, was wiederum den beiden HDV-Standards entspricht.

Eine ähnliche Idee verfolgt Focus Enhancements mit seinen andockbaren Diskrecordern, die es erlauben, die Camcorder-Daten in verschiedensten File-Formaten aufzuzeichnen, die dann direkt in Schnittsystemen verarbeitet werden können. Es gibt auch erste Produkte, die es erlauben, direkt im eigentlich für die Postproduction entwickelten Apple-Format ProRes 422 aufzunehmen (näheres im Abschnitt »Externe bandlose Aufnahmesysteme«).

Link-Übersicht: SD-Videoformate

Im unten angefügten PDF finden Sie eine Tabelle mit den Eckdaten der gängigen, aktuellen SD-Videoformate. Die folgenden Link-Liste führt zum Lexikon-Eintrag des jeweiligen Formats: DV, DVCPRO, DVCPRO50, DVCAM, Digital Betacam, IMX, XDCAM.

Link-Übersicht: HD-Videoformate

Im unten angefügten PDF finden Sie eine Tabelle mit den Eckdaten der gängigen, aktuellen HD-Videoformate. Die folgenden Link-Liste führt zum Lexikon-Eintrag des jeweiligen Formats: HDV, AVCHD, DVCPROHD, DVCPROHD EX, XDCAM HD, XDCAM EX, XDCAM HD 422, HDCAM, P2HD, HDCAM SR, Infinity/JPEG2000.

Auf dem Videoformatfriedhof

Von den ersten digitalen Videoformaten soll hier gar nicht mehr die Rede sein: D1, D2, D3, D6 und das DCT-Format sind längst Geschichte. Aber auch einige neuere digitale Videobandformate sind schon ausrangiert oder dümpeln nur noch auf Sparflamme vor sich hin: Digital 8, D5, D9, D5-HD,D9-HD, Betacam SX.

Raw-Formate

Es gibt recht verschiedene Formate, in denen Raw-Daten gespeichert werden. So können etwa die Digitalkamera D21 von Arri, die Weisscam, die SI-2K, die Phantom und die Red One im Raw-Modus betrieben werden und Daten in einem Raw-Format ausgeben.

Weder die Schnittstellen, noch die Raw-Formate sind im Bewegtbildbereich genormt, hier macht jeder Hersteller mehr oder weniger was er will. Im folgenden ist das Format der populären Kamera Red One des Herstellers Red Digital Cinema als Beispiel für ein Raw-Format herausgegriffen.

Redcode Raw: Die Red One wird derzeit besonders von Independent-Filmern stark beachtet: Sie verspricht kinotaugliche Bilder mit 4K-Auflösung zu vergleichsweise moderaten Preisen. Die Red One kann auf CF-Speicherkarten oder auf Festplatte aufnehmen. Hierbei verwendet der Hersteller das eigene Kompressionsverfahren Redcode Raw.

Dabei werden die Rohdaten des Bildsensors unter Einsatz eines Wavelet-Verfahrens mit variabler Bitrate komprimiert (ähnlich JPEG2000). Die maximale Datenrate kann dabei auf 224 Mbps oder auf 288 Mbps festgelegt werden, was einer Kompression von 12:1 und 9:1 entspricht, wenn man die Rohdatenrate zugrunde legt, die der Sensor abgibt. Aufgezeichnet werden dabei komprimierte Rohdaten, also keine RGB- oder Videosignale im engeren Sinn. Diese Daten müssen vor der Vorführung in jedem Fall bearbeitet und aufbereitet werden, was eher den Abläufen bei der Filmproduktion entspricht, als der klassischen Videoproduktion.

CF-Speicherkarten erreichen zudem nicht die für Redcode Raw festgelegten Datenraten, mit den Karten ist also keine Echtzeit-Wiedergabe möglich, sie dienen beim Einsatz mit Redcode Raw lediglich als Speichermedium, um Daten sichern und transportieren zu können, nicht als Wiedergabemedium.

Die einfachere und vor allem die Echtzeit-Wiedergabe von Red-Aufnahmen soll eine Festplatte mit integriertem Hardware-Decoder erlauben.

Codecs

Das Wort Codec ist als Kurzform für die Paarung aus Coder und Decoder entstanden. Der Coder verschlüsselt oder verändert Signale nach bestimmten Regeln, und der Decoder kann diese kodierten Signale empfangen, verarbeiten, die Verschlüsselung rückgängig und den Inhalt der Signale sichtbar machen.

Der Begriff Codec wird meist im Zusammenhang mit digitalen Kompressionsverfahren benutzt. Jenseits aller wissenschaftlichen Definitionen, wird als Codec meist ein ganzes Paket aus Kompressionsalgorithmus, Signalprotokollen und Dateiformaten bezeichnet. Unter dieser Definition ist die folgende Übersicht einiger im Profi-Videobereich genutzten »Codecs« zu sehen.

AVC bildet den Kern vieler neuer Codecs. Es handelt sich dabei im wesentlichen um das Kompressionsverfahren MPEG-4 und zwar in der Variante MPEG-4 Part 10 (Advanced Video Codec), auch MPEG-4 AVC genannt. Weil dieses Verfahren einem Standard ähnelt, den die ITU für den Bereich Telekommunikation unter der Bezeichnung H.264 standardisiert hat, liest und hört man als Bezeichnung hierfür auch AVC/H.264 oder MPEG-4 AVC/H264 und ähnliche Kombinationen. MPEG-4/AVC/H.264 nutzt die gleichen Transport- und Steuer-Protokolle wie MPEG-2.

AVCHD ist ein HD-Format für digitale Camcorder, das die Aufzeichnung von 1080i- und 720p-Signalen auf 8-cm-DVDs, aber auch auf SD-Karten normiert. Das Format nutzt die MPEG-4-

basierte AVC/H.264-Kodierung zur Video-Kompression und Dolby Digital (AC-3) oder Linear PCM für die Audio-Kodierung.

AVC-Intra ist ein HD-Kompresssionsverfahren, das die H.264-Rechenvorschrift nutzt, aber anders als das Consumer-Format AVCHD nur Intraframe-Kompression durchführt, also immer nur innerhalb eines Bildes komprimiert. Panasonic nutzt AVC-Intra in den jüngsten P2HD-Geräten, weil dieses Verfahren effektiver ist als der bislang von Panasonic genutzte DVCPROHD-Codec: Gleiche Bildqualität bei geringerer Datenrate oder bessere Bildqualität bei gleicher Datenrate. Panasonic setzt DVCPROHD und AVC-Intra parallel ein, es gibt Geräte bei denen man jederzeit zwischen den beiden HD-Codecs wählen und umschalten kann.

AVC-Ultra ist noch nicht verfügbar, wurde aber während der Messe NAB2009 von Panasonic angekündigt und soll hochwertige Aufzeichnungen mit hohen Datenraten realisieren: AVC-Ultra soll für 1080p und für ein einfacher zu handhabendes System zur Stereo-3D-Aufzeichnung eingesetzt werden. Damit setzt Panasonic dem Sony-Format HDCAM SR ein eigenes High-End-Videoformat entgegen, das aber bandlos auf P2-Speicherkarten aufzeichnen soll. Die maximal mit AVC-Ultra realisierbare Datenrate soll jenseits von 200 Mbps liegen und Panasonic will damit 1080p-Signale in 4:2:2 mit 10-Bit-Quantisierung aufzeichnen. In 1080i soll 4:4:4 mit 12 Bit möglich sein.

DNxHD ist ein Codec, den Avid entwickelte. Mit ihm lassen sich HD-Signale so effektiv komprimieren, dass man in vielen Fällen keinen Unterschied zu unkomprimierten Signalen sieht, aber auf deutlich niedrigere Datenraten kommt. DNxHD ist ein DCT-basierter Codec, der ausschließlich I-Frames produziert. Avid bietet bei DNxHD unterschiedliche Qualitätsstufen an: Zunächst waren das DNxHD 220 mit 10 und 8 Bit, sowie DNxHD 145 mit 8 Bit, weitere folgten nach der Markteinführung. Die Zahl nennt dabei die jeweils maximal mögliche Datenrate, die real verwendete Datenrate kann davon aber nach unten abweichen, je nach zugespieltem Format und Bildrate. Zwei Beispiele verdeutlichen das: Arbeitet man mit 1920 x1080i und einer Bildrate von 59.95, dann generiert DNxHD 220 eine Datenrate von 220 Mbps. Werden HD-Signale mit 1280 x 720p und einer Bildrate von 23.976 mit DNxHD 220 komprimiert, entstehen dagegen nur 87 Mbps.

DV arbeitet mit einer Quantisierung von 8 Bit und komprimiert die Daten mit dem Faktor 5:1. Hierfür wird ein mathematisches Verfahren, die diskrete Cosinus-Transformation eingesetzt (DCT). Mit Hilfe von DCT und weiteren Rechenoperationen werden die nicht relevanten Informationen innerhalb eines Bildes erkannt und dann gezielt weggelassen. Zudem werden die Helligkeits- und Farbanteile des Bildsignals nicht im Verhältnis 4:2:2, sondern im Verhältnis 4:2:0 (PAL) verarbeitet. DV arbeitet mit einer Videodatenrate von rund 25 Megabit pro Sekunde (als Mbit/s oder Mbps abgekürzt).

Flash ist ein im Web weit verbreitetes Videoformat, das bisher in professionellen Camcordern nicht eingesetzt, sondern eher in der Distribution verwendet wird.

JPEG2000 ist ein standardisiertes Kompressionsverfahren für Bilder auf Basis der Wavelet-Transformation (siehe Erläuterungen bei Wavelet). Eine Besonderheit von JPEG2000 besteht darin, dass man die gleichen Dateien in verschiedenen Auflösungen darstellen kann, man muss also Proxies oder Low-Res-Versionen nicht speziell erzeugen, sondern kann diese direkt aus der Originaldatei lesen.

MPEG ist ein standardisiertes Kompressionsverfahren, das sich speziell zur Datenreduktion von Bewegtbildern eignet. MPEG ist ein asymmetrisches Kompressionsverfahren, das Kodieren ist erheblich aufwändiger als das Dekodieren. Wichtig hierbei: MPEG schreibt zwar das Datenformat und die Dekodierung genau vor, wie die Daten erzeugt werden, ist dagegen Sache des Herstellers. Jeder kann beim Kodieren seine eigenen Techniken und Algorithmen einsetzen, solange am Ende normgerechte MPEG-kodierte Datenströme entstehen, die sich mit jedem standardgerechten MPEG-Decoder lesen und wiedergeben lassen. MPEG komprimiert nicht zwingend nur einzelbildweise (Intraframe), sondern kann darüber hinaus auch die Daten mehrerer aufeinanderfolgender Bilder analysieren und die daraus gewonnenen Information für die Kompression nutzen (Interframe). Die Einzelbilder einer Videosequenz setzen sich gemäß MPEG-Standard aus I-, B- und P-Frames zusammen. Der MPEG-Standard bezeichnet die Folge von I-, B- und P-Frames als Group of Pictures (GoP). Eine GoP muss mindestens ein I-Frame enthalten. MPEG-2, das derzeit im Profibereich am weitesten verbreitete MPEG-Verfahren, ist in verschiedene Profiles und Levels unterteilt, für die jeweils unterschiedliche Eckdaten festgelegt wurden: Datenraten, GoP-Strukturen, die Auflösung, also die Anzahl der Zeilen und Pixel, sowie Sampling und Bildwechselfrequenz.

ProRes 422 von Apple wurde für die Postproduktion entwickelt. Das Ziel war es wie bei DNxHD von Avid, HD-Signale so effektiv zu komprimieren, dass man in vielen Fällen keinen Unterschied zu unkomprimierten Signalen sieht, aber auf Datenraten kommt, die nur wenig über denen von unkomprimierten SD-Videodatenströmen liegen. ProRes 422 produziert ausschließlich I-Frames, was in der Postproduction generell ein klarer Vorteil ist, weil weniger Kodierarbeit anfällt, was den Prozessor entlastet und schnelleres unkomplizierteres Arbeiten ermöglicht.

Wavelet wird als Kurzform für ein mathematisches Verfahren namens diskrete Wavelet-Transformation (DWT) verwendet. Dieses Verfahren kann unter anderem zur Bildkompression verwendet werden. JPEG2000 beruht auf Wavelet, auch die Red One nutzt Wavelet um die Raw-Daten der Kamera zu komprimieren. Auch bei höheren Kompressionsfaktoren treten mit Wavelet deutlich weniger sichtbare Bildfehler (Artefakte) auf, allenfalls lokale Störungen, die sich im Bild als Unschärfen äußern und dadurch weit weniger auffallen.

Link-Übersicht: Bandlose Speichermedien

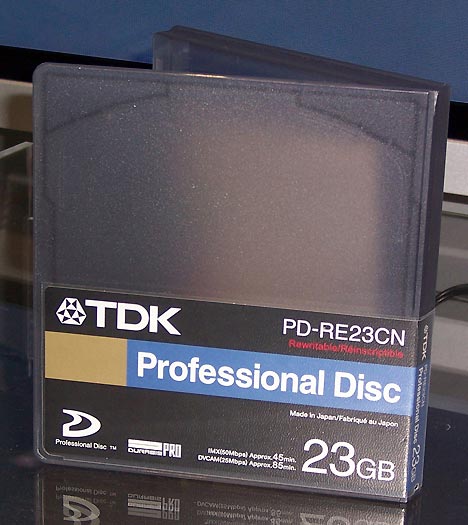

Im unten angefügten PDF finden Sie einen Abschnitt in dem die wichtigsten Infos zu den gängigen bandlosen Speichermedien aufgeführt sind. Die folgenden Link-Liste führt zum Lexikon-Eintrag des jeweiligen Speichermediums: P2, SxS, Professional Disc, CF-Card, SDHC-Card, Memory Stick, GF-Pak, Rev Pro, FieldPak.

Externe bandlose Aufnahmesysteme

Der Trend geht in der Film- und Videoproduktion ganz klar in Richtung bandloser, file-basierter Abläufe und ebensolcher Aufnahmesysteme. Hierbei gibt es neben den integrierten bandlosen Camcordern auch weitere Optionen aus dem Zubehörbereich,Der Trend geht in der Film- und Videoproduktion ganz klar in Richtung bandloser, file-basierter Abläufe und ebensolcher Aufnahmesysteme. Hierbei gibt es neben den integrierten bandlosen Camcordern auch weitere Optionen aus dem Zubehörbereich. Über Schnittstellen wie SDI, IEEE-1394 oder USB 2.0 kann heute an viele Camcorder auch ein portabler Diskrecorder angeschlossen werden, der dann parallel oder alternativ zum eingebauten Laufwerk des Camcorders die Bild- und Tondaten speichert. Solche Diskrecorder gibt es von den Camcorder-Herstellern Sony, JVC und Panasonic, sowie von weiteren Anbietern, unter denen Focus Enhancements mit seiner Firestore-Familie zu den populärsten und erfolgreichsten zählt. Die Besonderheit der Firestores besteht darin, dass diese Geräte eine Vielzahl von Dateiformaten unterstützen und es erlauben, die Daten gleich so auf die Platte zu schreiben, dass das jeweils gewünschte Schnittsystem direkt auf die Dateien zugreifen kann. Im folgenden ist eine Auswahl weiterer externer bandloser Aufnahmesysteme zusammengestellt.

Aja hat mit Ki Pro einen portablen, <LEX>timecode</LEX>-fähigen Diskrecorder im Programm, der das Kamerasignal direkt im Format ProRes 422 von Apple aufzeichnet. Digitale Signalquellen finden per HD/SD-SDI- und HDMI-I/O Anschluss. Das Gerät besitzt auch analoge Komponenten-I/Os sowie einen Composite-Ausgang. Analoge Audioquellen können per XLR oder Cinch angeschlossen werden, digitaler Ton als Embedded Audio im SDI-Signal (8-Kanal) oder per HDMI (2-Kanal).

Die Aufzeichnung erfolgt wahlweise auf eine Wechselfestplatte mit integrierter FireWire-800-Schnittstelle oder auf Flash Express-Card 34. Per Ethernet-Anschluss und integriertem WiFi ist es möglich, Ki Pro per Web-Browser einzurichten und zu steuern. Die Aufnahmefunktionen sind durch die Kamera über Firewire-400 oder LANC fernsteuerbar.

Codex Portable ist ein wetterbeständiger Set-Recorder, der rund 4 kg wiegt. Es eignet sich zur Aufnahme von 4K-Daten, sowie von HD-Material in den Formaten 1080p/i und 720p. Der Recorder bietet vier HD-SDI-Eingänge. Per Dual-Link können zwei Signale in RGB-4:4:4 verarbeitet werden, beispielsweise bei einer Stereo-3D-Produktion. Mit YCrCb-4:2:2-Signalen ist eine simultane Aufzeichnung von vier SDI-Quellen möglich.

Bis zu sechs Portables können synchronisiert und bei Multi-Kamera-Produktionen als 24-Spur-Videorecorder genutzt werden. Codex Portable arbeitet mit JPEG2000-Kompression und komprimiert die Daten im Verhältnis von 3:1 bis 8:1. Gespeichert wird auf speziellen Disk-Packs des Herstellers. Diese sind als wechselbare <LEX>Raid</LEX>-3-Festplatten-Laufwerke mit 400 oder 800 GB Kapazität ausgeführt. Auch die herstellereigenen Flash-Drives in SSD-Technik mit 128 bis 512 GB sind optional verwendbar.

Convergent bietet mit NanoFlash einen kleinen Recorder an, der HD-Signale auf CF-Speicherkarten aufnimmt. Video, Audio und Timecode werden über eine <LEX>HD-SDI-</LEX>Schnittstelle eingespielt. Mit 106 x 94 x 36 mm und weniger als 10 W Leistungsaufnahme, gibt sich NanoFlash mit wenig Platz und Leistung zufrieden. Im Unterschied zum größeren Flash XDR von Convergent, kann der kleine Nano nur Embedded Audio verarbeiten, hat also keine Audioschnittstellen.

Nano kann mit einem Camcorder-Akku betrieben werden. Als Codec kommt 4:2:2-MPEG-2 zum Einsatz, die Datenrate kann im Long-GoP-Modus auf 50 oder 100 Mbps eingestellt werden, I-Frame-only sind 100 oder 160 Mbps möglich. Gespeichert wird im MXF-Format. Das System kommt ohne Lüfter aus, bietet also geräuschlosen Betrieb.

FFV hat mit Elite HD einen Festplattenrecorder im Programm, der sich zwischen Akku und Kamera montieren lässt. Der andockbare JPEG2000-Recorder ist mit zwei Akku-Anschlüssen lieferbar: Anton/Bauer Gold- oder V-Mount. Bei Intraframe-Kompression und einer Quantisierung von 10 Bit bietet der Elite HD 4:2:2-Signalverarbeitung.

Der Recorder verarbeitet bis zu acht eingebettete Audio-Kanäle. Mit der Außenwelt kommuniziert der Elite HD über HD-SDI. Die Daten werden auf 2,5-Zoll-SATA-Wechselfestplatten gespeichert, die im laufenden Betrieb austauschbar sind. Optional ist RS-422-Steuerung möglich.

Focus hat den Festplattenrecorder Firestore FS-5 für den Anschluss an alle gängigen DV- und HDV-Camcorder konzipiert. Der FS-5 beherrscht zahlreiche Dateiformate, kann also gleich in dem Format aufzeichnen, mit dem das nachgeordnete NLE-System arbeitet. Der FS-5 bietet neben Firewire auch USB 2.0 und ein Farb-Display. Metadaten können per Handy, Laptop oder Handheld-PC schon während der Aufzeichnung kabellos eingegeben und mit dem Videomaterial gespeichert werden.

Neu bei Focus ist der FS-H200, der DV- und HDV-Camcordern die direkte Aufzeichnung auf Compact-Flash-Karten ermöglicht — ähnlich wie Sonys CF-Recorder HVR-MRC1.

Fraunhofer IIS hat mit MicroStorage einen kompakten Speicherkarten-Recorder entwickelt, mit dem sich Bildsignale via HD-SDI auf CF-Karten aufzeichnen lassen. Der Recorder ist mit einem H.264-Encoder bestückt, der auf bis zu 20 Mbps komprimiert und die Bilddaten in Echtzeit speichert. Mit einer 32-GB-Karte soll es möglich sein, bis zu zwei Stunden Material aufzuzeichnen.

Eine Besonderheit bei der Wiedergabe besteht darin, dass sich die CF-Card mit jedem PC lesen und der gespeicherte Transport-Stream direkt wiedergeben lässt. Audiosignale lassen sich in den MicroStorage als Embedded Audio via HD-SDI einspielen. Die Berliner Firma Mikro M vertreibt MicroStorage.

JVC hat mit dem KA-MR100G einen SxS-Dockrecorder im Programm, der sich mit dem Schultercamcorder GY-HM700 nutzen lässt. Auf die SxS-Karten wird im MP4-Format aufgezeichnet. Der SxS-Dockrecorder lässt sich am GY-HM700UXT ohne Adapter anflanschen.

Panasonic bietet mit dem HMR10 einen Speicherkarten-Recorder im AVCHD-Format an. Er ist mit einem HD-SDI-In und -Out bestückt und speichert auf SDHC-Karten. Eine Stereo-Mikrofonbuchse bringt der HMR10 mit, sowie HDMI-Out und USB 2.0.

Zudem verfügt das Gerät über Timecode-Funktionalität. Lautsprecher und 3,5-Zoll-LCD-Monitor erlauben die Signalüberwachung und die Wiedergabe des Materials.

Sony hat mit dem PXU-MS240 ein Gerät entwickelt, mit dem sich SxS-Speichersticks auf Wechselfestplatten umkopieren lassen. Das Gerät verfügt über einen eSata-Anschluss, der es erlaubt, direkt vom Schnittsystem aus mit dem auf der Wechselplatte gespeicherten Material zu arbeiten, ohne es vorher umkopieren zu müssen. HVR-MRC1 heißt ein CF-Karten-Recorder von Sony, der an die Camcorder Z5, Z7 und S270 angedockt werden kann.

S Two hat das On-Set-Speichersystem OB 1 entwickelt. War das Unternehmen bisher für große, schwere, festplattenbasierte Systeme bekannt, ist OB 1 nun eine kompakte Einheit mit 2,5 kg, die sich wie ein Filmmagazin an Kameras wie Arris D21 oder Sonys F35 befestigen lässt.

Das Speichersystem arbeitet mit speziellen Flash-Drives, die als Wechselmedien ausgeführt sind. OB 1 kann über den Gleichstromausgang der Kamera mit Spannung versorgt werden. Der OB 1 braucht keinen Lüfter, bietet also geräuschlosen Betrieb. Der OB 1 kann laut Hersteller Signale mit Bildraten bis zu 60 fps unkomprimiert speichern, es ist möglich, DPX-Files oder Arri-Raw-Daten aufzuzeichnen, HD geht auch, mit 4:4:4.

Das Gerät bietet De-Bayering, der Anwender kann drei LUTs in den OB 1 laden.

Downloads zum Artikel: